👀日报&周刊合集 | 🎡生产力工具与行业应用大全 | 🧡 点赞关注评论拜托啦!

👀 WPS 道歉:承诺用户文档不会被用于 AI 训练

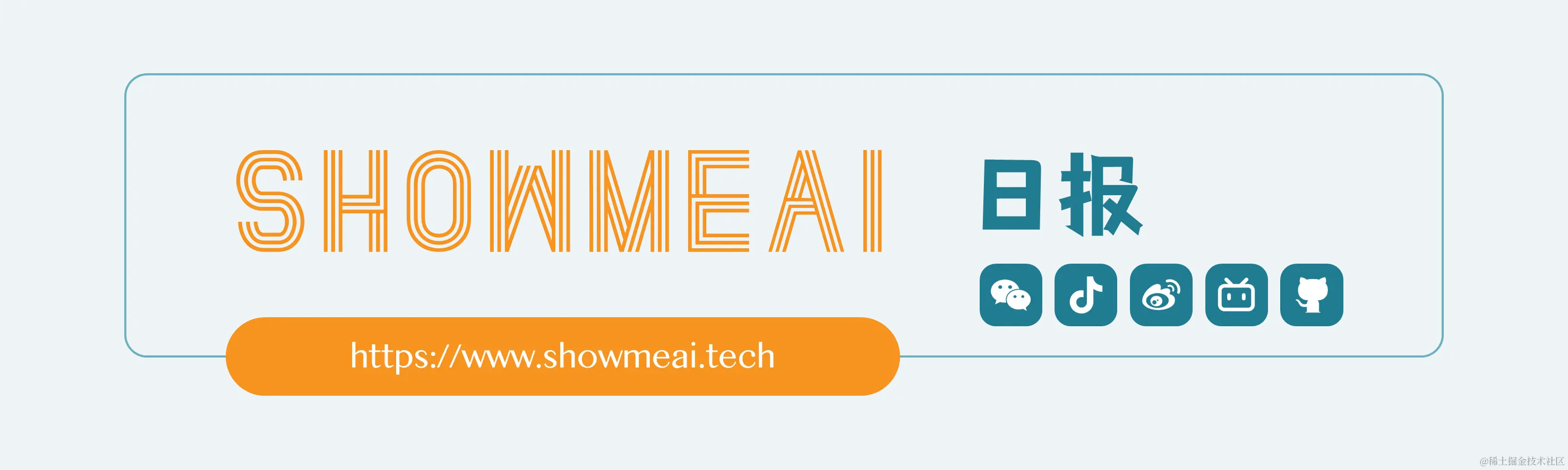

11月16日,国内头部办公软件和服务提供商「金山办公」宣布「WPS AI开启公测」,并修改了WPS隐私政策。同一天,豆瓣用户 @momo 发帖讨论最新版隐私政策中存在不安全条款,引发了用户们对信息安全的担忧。

为提升您使用我们提供的包括但不限于在线文档美化、在线PPT美化、在线表格美化的AI功能的准确性,我们将对您主动上传的文档材料,在采取脱敏处理后作为AI训练的基础材料使用。

同时请您放心,我们将采取严格的安全措施和技术手段对该资料进行去标识化处理,以降低其他组织或个人通过去标识化处理后的个人信息识别到您的风险、保护您的个人信息。

11月18日,WPS官方微博发布声明,宣布更新了隐私政策、去除了容易引起误会的表述,确保产品使用过程完全符合数据安全及个人信息保护的相关法律法规之规定。同时郑重声明,所有用户文档不会被用于任何AI训练目的,也不会在未经用户同意的情况下用于任何场景。

🉑 OpenAI 大戏反转再反转,决定人类命运的这个周末

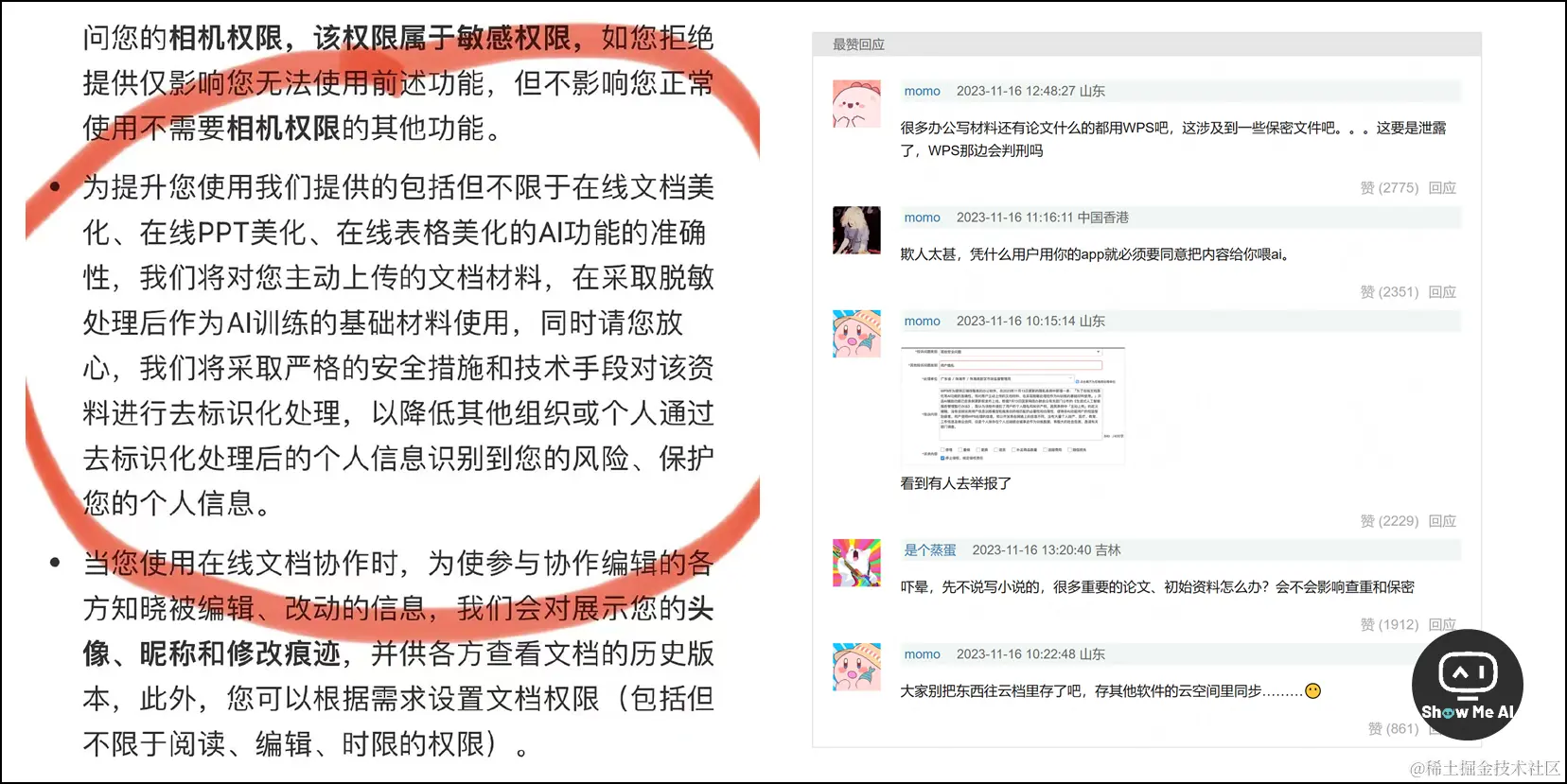

周六早上,刚醒就看到了一条炸裂的新闻,OpenAI CEO Sam Altman 被炒了,董事长 Greg Brockma 被取消董事会席位后选择愤然辞职。随着 Sam Altman 和 Greg Brockma 陆续发推证实,群里开始了各种「阴谋论」的猜测。

周日中午,开始有大投资方微软下场、邀请 Sam Altman 重回 OpenAI 的消息。这时大家普遍以为一场卡bug的闹剧即结束,只待各方顺水推舟回归正轨,并开始为操纵者 Ilya Sutskever 的下场担心。

周一中午,获知 Sam Altman 重回 OpenAI 的谈判破裂。OpenAI 董事会任命了新的 CEO Emmett Shear,而微软 CEO Satya Nadella 稍后宣布 Sam Altman 和 Greg Brockma 加入微软,领导新的AI高级研究团队。

周一晚上,OpenAI 的 95%+ 员工签署联名信,称除非该公司董事会辞职并重新任命被赶下台的首席执行官 Sam Altman,否则他们可能辞职并加入微软。而 Ilya Sutskever 也署名了这封信,事情再次迎来反转。

如上图所示,今天在梳理资料时看到了 OpenAI 网站首页的「Creating safe AGI that benefits all of humanity」

我们先讨论当前的已知未知,等事件走向更稳定和清晰时,日报再整理事件的完整时间线。

已知1:OpenAI 此前已经出现了严重的「路线分歧」,并且激烈到了无法调和的程度,因此保守派联合中间派现场干掉了激进派

已知2:OpenAI 承受着巨大的「财务压力」,甚至到了入不敷出的程度,因此激进派 Sam Altman 为了引进更多外部资金 (或者还有更多训练数据) 而让渡了 OpenAI 的核心利益 (可能是独立性)

未知1:OpenAI 发布的官方声明中提到的 Sam Altman「he was not consistently candid in his communications with the board (他在与董事会的沟通中并不坦诚)」是指什么,是 Sam 跟投资方接触时的谈判条件,还是 Sam 自己做了什么其他项目

未知2:OpenAI 是否取得了巨大的技术进步, Ilya Sutskever 是否在其中看到了AI技术可能脱离人类掌控的具体可能性

未知3:OpenAI 能否持续稳定地提供服务以及是否会开源部分技术/模型,Sam 是回 OpenAI or去微软以及是否能延续上一段辉煌,国内外各大厂是否趁这段时间奋起直追……

👀 OpenAI 事件核心角色新路历程:Ilya 在坚持什么

最近两三天,OpenAI 这件事占据了几乎所有科技版的头条,而且天天有反转,次次想不到。相关的解析文章很多,「微软阴谋论」等各种判断也贡献了很多故事版本。

这篇知乎回答是目前看到的、最通俗易懂的解释,作者认为二人最大的矛盾是 AGI 发展的理念之争,并从时间和人物线上分析了 OpenAI 为什么这么坚持「安全」。以下整理作者的核心观点:

深度学习三巨头观点迥异:Geoffrey Hinton 是典型的悲观派,认为 AI 就像潘多拉的魔盒一样,一旦打开就无法关闭,终将威胁到人类自身;在一路狂奔前应该先想清楚其中的风险与伦理,并为此规划好技术路线和安全底线;Yann LeCun 是个乐观派,Yoshua Bengio 观点比较中立

开始,OpenAI 成立之初,参与者们 (Ilya、Greg、Musk、Hoffman、Thiel、甚至 Sam 本人) 深受 Geoffrey Hinton 的观点影响,因此将「AI安全」刻进了组织的基因里,成为不可逾越的底线

去年,ChatGPT 上线并意外爆红后成本激增,成为实打实的吞金兽,Sam 为了生存发展反复游走在底线边缘,不仅设计了复杂的股权架构,避免 OpenAI 在融资过程中丧失控制权,还在积极推进商业化,一切都在向好的方向发展

随后,Sam 为了推高公司估值并进一步融资,推出了更激进的商业发展策略 (比如开发者大会上发布的未来商业版图),这些彻底越界的动作让 Sam 和 Ilya 发生了巨大的理念冲突

最后,Ilya 觉得 Sam 背弃了当初的信仰 (可能还有别的原因),参与了这场激烈的公司内部斗争,并且在后续谈判中没有妥协

应该说,Sam 最开始认同 OpenAI 的理念,他没有股权也没有薪酬的几年奔忙也是为了信仰;但是最近一年的空前成功催大了他的野心,他描绘的发展宏图让 OpenAI 自带的「AI安全」基因警惕起来,并被亲手设计的股权结构踢出了局

🉑 天才还是莽夫?我们都需要重新认识 Ilya Sutskever

Ilya Sutskever 是 OpenAI 的首席科学家,也是最重要、最有哲学性的科学家。他并不是莽夫,这个11分钟的采访短片足以管中窥豹他的思考深度,并感受到他说的「AI安全」不是虚无缥缈的科幻想象。

现在回想起来,他其实一直在发声,从3月份与 Lex Fridman 深度对话、4月份接受黄仁勋的深度访谈、6月在列特拉维夫大学的圆桌讨论到近期的采访和播客分享。只不过我们的目光被 Sam Altman 和 OpenAI 一轮轮的技术创新所吸引,并没有安静下来听听他的表达。

现在,是时候让我们重新认识 Ilya Sutskever 了!

在这个采访短片中,Ilya 认为我们终将实现 AGI (通用人工智能),或许很快或许还要再等等。但是!第一批人工智能的信念非常重要,否则系统将按照进化的本质将自身的发展作为首要目标 (因为人类进化就是首先考虑自己的)。

这样发展下去会导致,强大的人工智能与人类的关系,变成现在「人类与动物」的关系:人类对动物也很不错,但是当人们确立自己的发展目标时,并不会征求动物的许可。

那么解决方案是什么呢?就是让 AI 对齐那种底层的「对人类无条件的爱」。但是这通过现有的对齐技术和 RLHF 注入,可能无法做到。

那不能先推出 AGI 再修正呢?Ilya 认为不能!既然技术的本质类似于人类的生物进化,那么进化的起点很重要。如果AI进化的起点里没有「对人类无条件的爱」,那最终也一定会把我们人类带到沟里去。

可能的确存在一些决定性因素,不仅激化了与 Sam Altam 之间的矛盾,还让他判断必须要按下减速键,哪怕代价是 OpenAI 失去了一位堪称卓越的 CEO,并引起科技圈的一轮大风暴 ⋙ 阅读这篇分析你将了解更多

🉑 创业者眼里的 Google 世界:被收购后开心、震撼与无奈

这篇文章几天前就已入选日报选题,不过时值 Sam Altam 可能离开 OpenAI 加入微软、后者股价狂飙猛进的时刻,感觉阅读起来又有了另一番的意味。

微软 + Sam Altman = ?如果「钱+人+技术+先发优势=成功」,那要怎么解释 Google 错过了这轮大模型浪潮的领先地位,甚至跟跑也有点吭哧吭哧呢?

Socratic 是一家教育初创公司,开发的同名应用可以帮助学生解答各种学科的问题,被在2018年3月被 Google 收购。作为公司 10 人团队中的一员,作者亲历了初创公司发展、融资、被Google收购、重构应用、选择离职的全过程。

被 Google 收购收购后,作者作为产品和工程负责人,在参与的种种细节中,被这家世界知名大厂的人才密度和资源厚度深深震撼:

以 Google 内部极高的标准重建产品,借助公司极高的人才储备突破了技术难题,并在Google 生态内或者了超出预期的增长

可以使用 Google 的巨大代码仓库和强大的软硬件基础设施,可以查看海量的内部资源、数据和文档

背靠 Google 这块金字招牌,可以使用其全球的办公资源,并享受到优渥的生活

但是,新鲜劲儿过去之后,作者感受到了身处这个「庞然大物」中的各种无奈,逐渐褪去了滤镜更清晰地看到了这其中的弊端:

内部审批流程非常复杂,而且文山会海,导致执行远多于思考

当一个创新的想法需要与各方沟通几十上百次时,很明显,这里的土壤已经不适合培育创新了

内部目标和组织架构频繁变动,必须跟领导目标对齐才能推进项目,而且还可能遭遇内部团队的竞争,这有利有弊

员工都是聪明人,会让一些聪明的歪脑筋和投机者获益,比如反对者比创造者更有话语权、领导明哲保身、为了晋升瞎编乱造等

👀 15个官方Tips,手把手教你成为更好的 AI 提示词工程师

微软的官方博文中,有不少关于提示词创建和优化的教程,不过英文的居多。这篇文章是微软 Azure 云科技官方公众号的翻译和整理,呈现形式超级友好而且读起来非常丝滑~ 可以当作优质的中文学习资料收藏起来啦~

掌握基础知识

识别提示组件

创建明确的指令

使用「示例」

注意提示线索

测试排布顺序

给模型一个「出口」

注意 Token 限制

采用负责任的AI来减轻风险

实验和迭代

了解不同的API

从清晰的系统消息开始

利用小样本学习

使用显式约束

结合多种技术处理复杂任务 ⋙ 阅读原文

🉑 从第一性原理看大模型Agent技术

第一性原理 (First Principles )是指从最基本的原理出发进行思考和解决问题的方法

最近,越来越多的人将目光投向 Agent「智能体」,并认为相比于仅具备单向输出能力的GPT语言模型,具有「感知-决策-执行」闭环能力的 Agent 更有可能成为实现 AGI 的路径。那么,让我们通过这篇长文来解答很多人灵魂深处的提问:到底啥是 Agent。

一、从 Prompt 工程到 Agent 的技术演进历程

Prompt 工程:利用 Prompt 提示的方式调用 LLM 完成简单任务

Prompt 外挂:为弥补 LLM 的局限性,提供外部插件和工具

分解与组合:将复杂任务拆分为多个子任务,提高任务完成能力

反馈:引入反馈机制,让LLM的输出反馈为下一次输入

Agent:实现闭环感知、决策、执行的智能体

Multi-Agent:多个Agent协同工作,提高任务规模和复杂度

二、通用智能基本原理

认知架构的双系统假说:系统1快速反应,系统2逻辑思考

面向目标架构:消除当前状态和目标状态差异的过程

三、面向目标架构的应用现状和局限性

GPS:基于目标状态搜索可达解空间

PDL:过程描述语言,通过目标状态反向搜索执行过程

软件工程中的应用:声明式编程面向目标,过程式编程面向过程

四、Agent技术发展方向

Central Executive:明确内部决策过程

Memory:区分工作记忆和长期记忆

Sensory:支持多模态输入

Motor:优化输出方式,提高带宽

Learning:判断自身可靠性,控制输出权威性

World Models:整合信息,构建无矛盾知识体系 ⋙ 文字版阅读

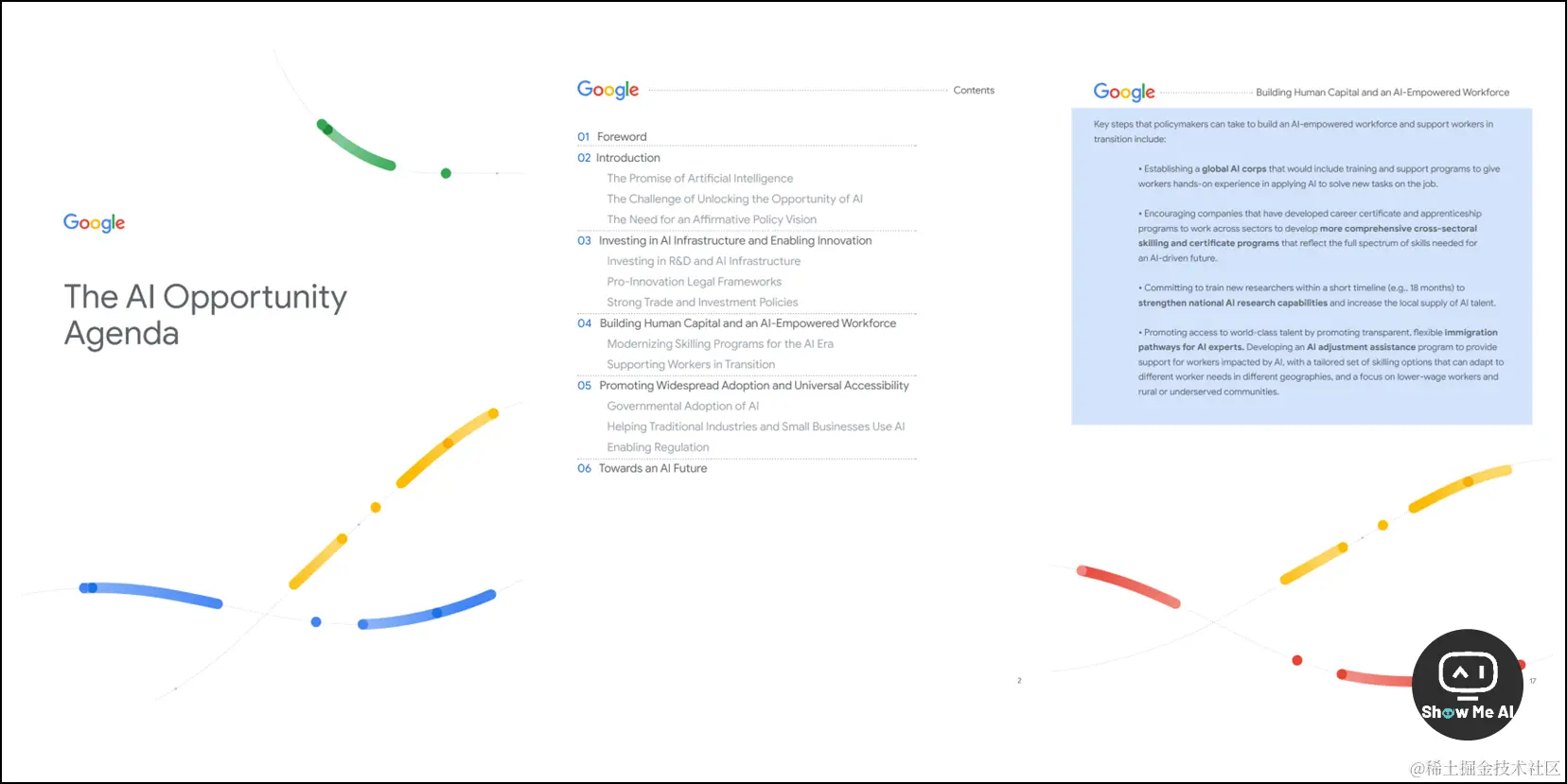

👀 Google 发布「AI机遇议程」文件,为政府提供了这些建议

ShowMeAI知识星球资源编码:R192

11月14日,Google 发布了「An AI Opportunity Agenda (AI机遇议程)」文件,呼吁各界关注人工智能带来的机遇大于风险,并为政府提供了具体的实施建议,比如在投资AI基础设施和创新、建设人力资本、推广使用等方面加强合作,共同推进人工智能的发展,使其造福全人类。

人工智能(AI)具有巨大的潜力,可以帮助解决一些我们这个时代面临的重大挑战,如公共卫生、经济增长等。但是要实现AI的潜力,需要政府、企业和公民社会共同努力

为释放AI的机遇,需要在三个方面积极作为

投资AI基础设施和创新:支持AI研发和基础设施建设,建立有利于创新的法律框架,形成强大的贸易和投资政策

建设人力资本和赋能AI的劳动力:通过现代化的培训方案,支持转型中的劳动者,建设一个以AI为能力的劳动力

推广使用和普惠性:政府采用AI来改善公共服务,帮助传统行业和小企业采用AI,建立有利于AI健康生态的监管环境

- 为实现这些目标,文章提出了许多具体建议,如建立全球AI研究资源平台、更新版权框架、实施风险基础的AI监管、建立全球AI部队、帮助小企业采用AI等

感谢贡献一手资讯、资料与使用体验的 ShowMeAI 社区同学们!

◉ 点击 👀日报&周刊合集,订阅话题 #ShowMeAI日报,一览AI领域发展前沿,抓住最新发展机会!

◉ 点击 🎡生产力工具与行业应用大全,一起在信息浪潮里扑腾起来吧!

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)