我正在参加「掘金·启航计划」

Web LLM 将大型语言模型和基于 LLM 的聊天机器人引入 Web 浏览器。让一切都在浏览器内运行而无需服务器支持(使用 WebGPU 加速)。

这无疑产生了许多有趣的机会,这样做可以为每个人构建 AI 助手,还可以在享受 GPU 加速的同时实现隐私保护。项目相关信息如下:

- 开源地址:github.com/mlc-ai/web-…

- 支持模型:lmsys/vicuna-7b-delta-v0(微调

LLaMA,号称能达到GPT-4的 90%性能)

这个项目 04-14 才开源,很多地方还没有很完善,如文档或者运行示例等,但是在浏览器中运行实在是吸引人,正好手头有一台 M1 的 MacOS,所以赶紧来体验一波。

在线体验

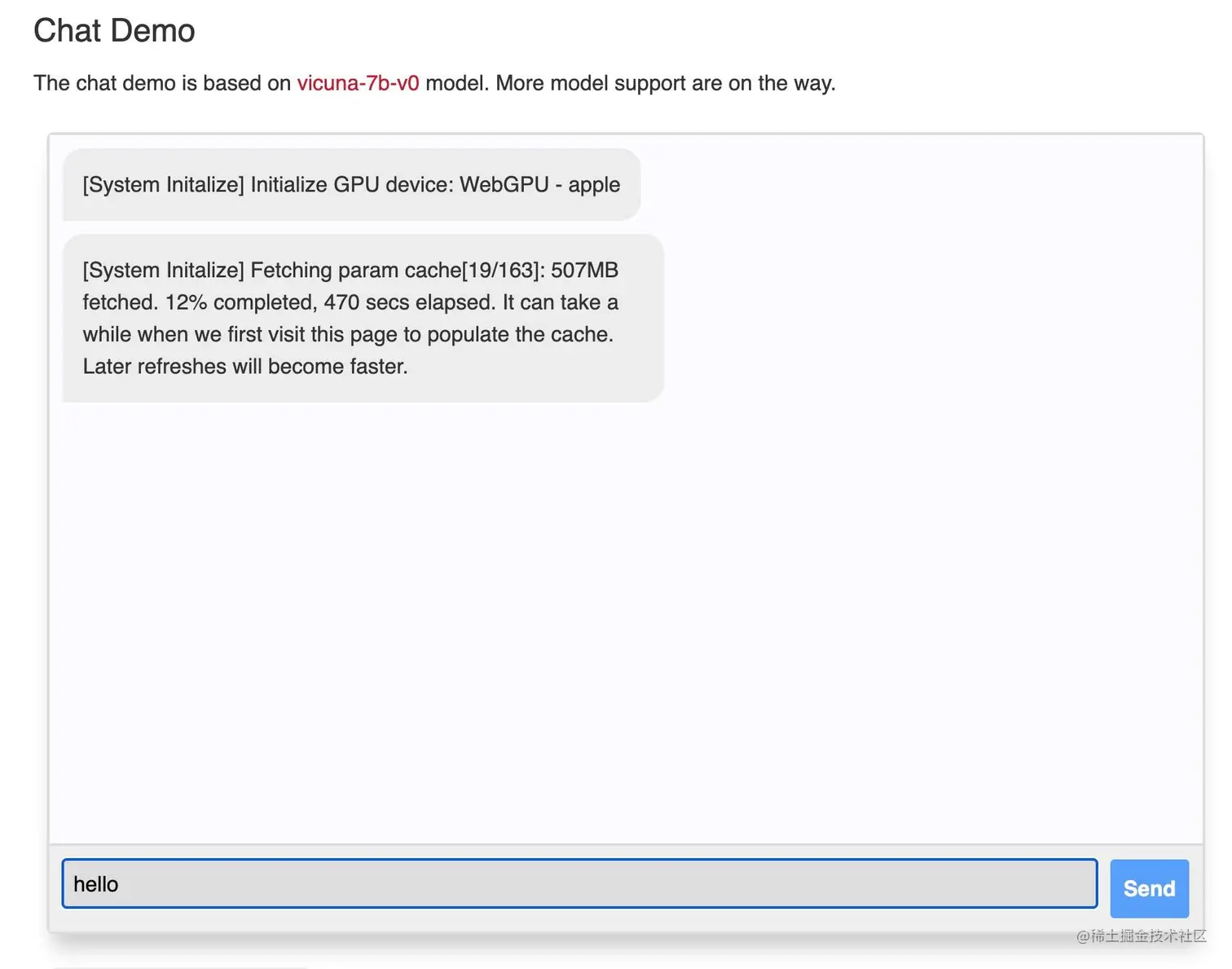

官网直接给了一个 Apple 芯片的 Mac 电脑本地使用的例子,步骤简单,如下:

- 下载 Chrome Canary,目的是为了体验最新版的

WebGPU功能(也可以试用最新的 Chrome 113) - 安装好之后,命令行启动 – 记得启动前设置好代理,方便下载模型参数 –

/Applications/Google Chrome Canary.app/Contents/MacOS/Google Chrome Canary --enable-dawn-features=disable_robustness - 开始体验!

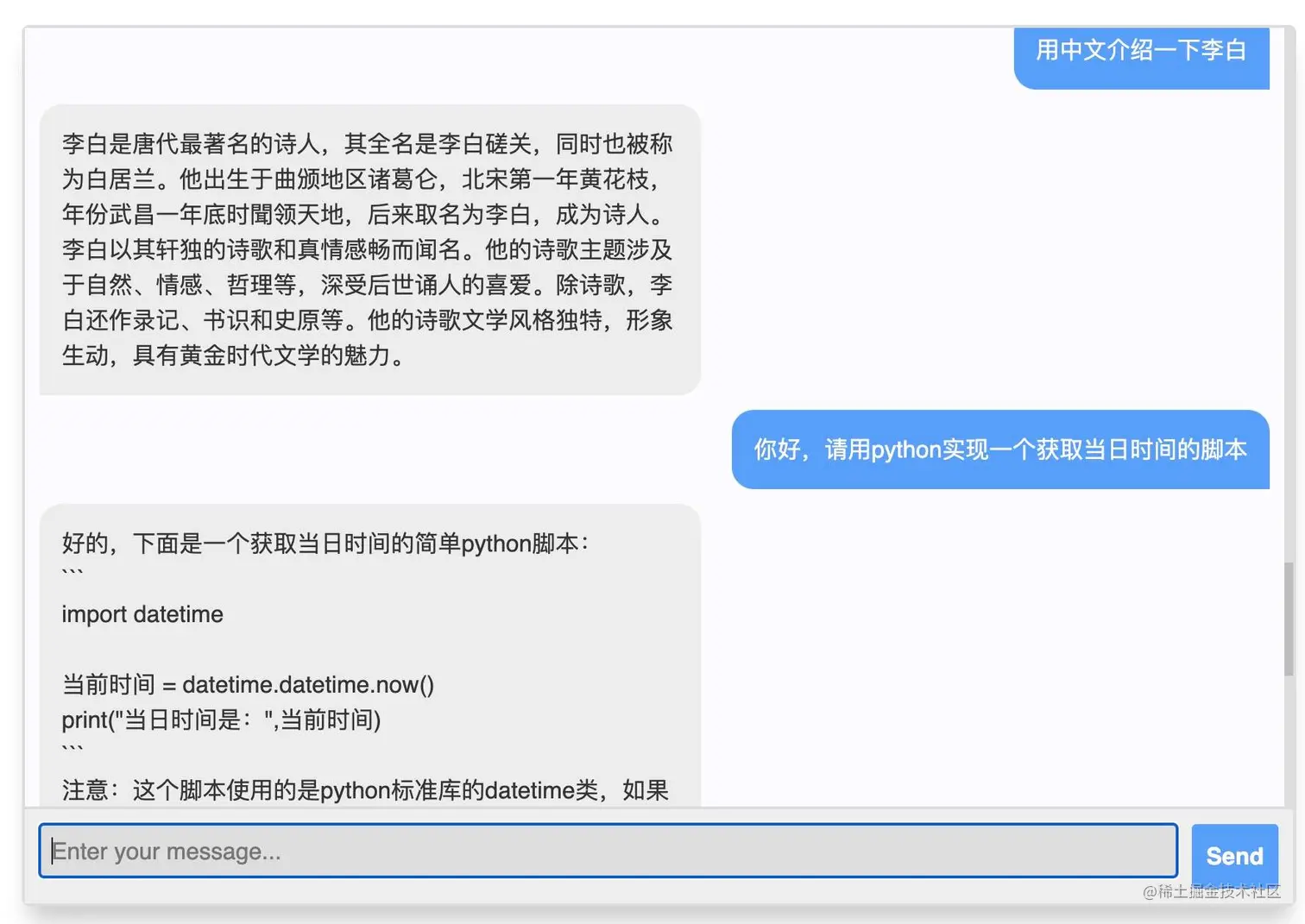

等待下载完毕,就可以直接使用了:

可以看到,明目张胆地胡乱介绍我们的李白,测了下写代码还是能行的。

本地体验

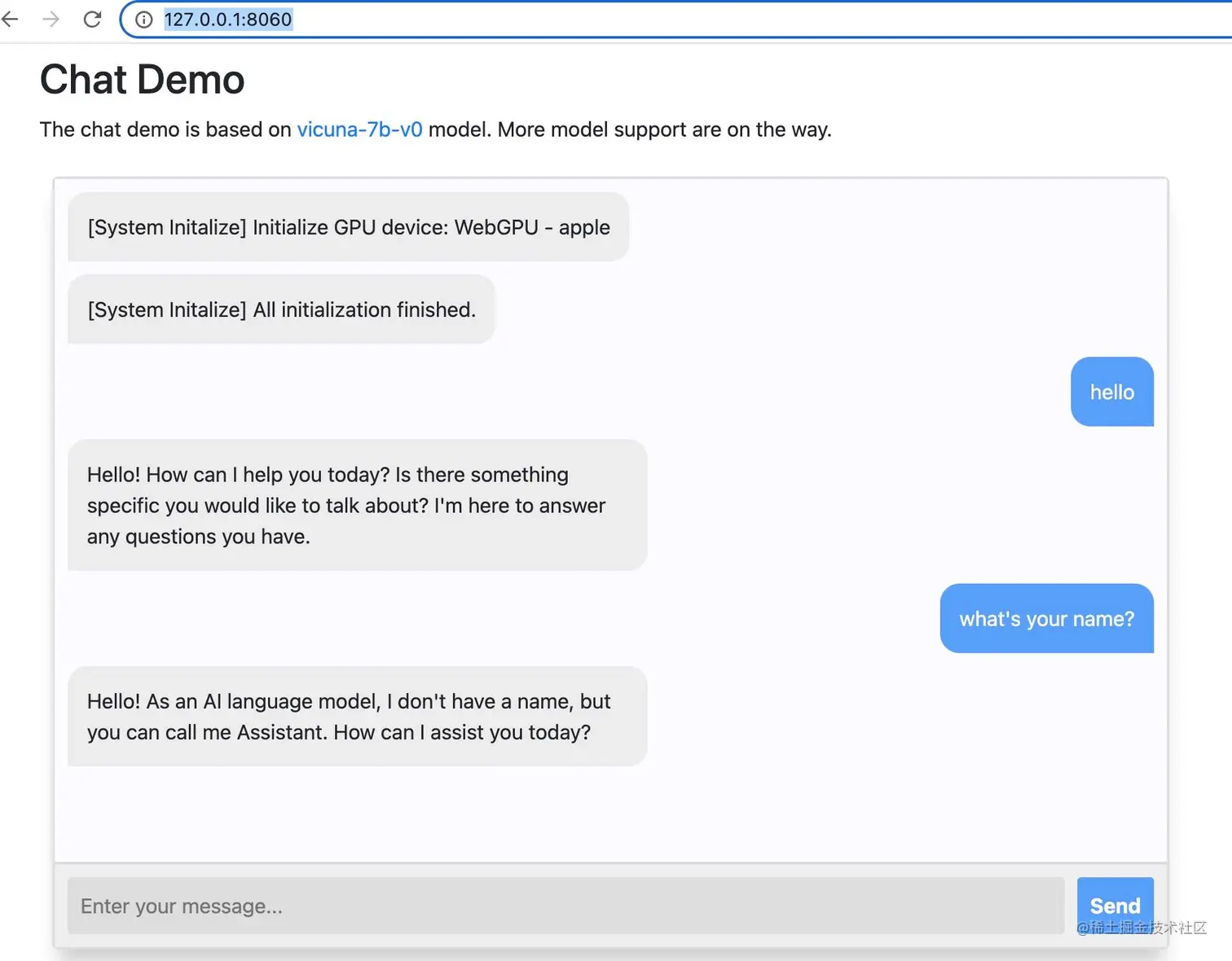

这块官方也还没有说怎么本地启动运行,我是个人觉得因为是基于浏览器,所以本地运行应该就是启动一个网站。

测试也很方便,我就直接把相关源码 clone 下来,然后启动,发现果然可行,看过程如下:

shell复制代码git clone https://github.com/mlc-ai/web-llm # switch branch cd web-llm git checkout -b gh-pages origin/gh-pages cd docs # start docker run --restart always --name docker-web-llm -p 8060:80 -d -v "`pwd`:/usr/share/nginx/html" nginx

启动浏览器:

shell复制代码/Applications/Google Chrome Canary.app/Contents/MacOS/Google Chrome Canary --enable-dawn-features=disable_robustness

在浏览器输入:http://127.0.0.1:8060/, 即可在你的本地体验 vicuna-7b 模型了,相当简单:

说明

至此,线上线下体验 Web LLM 至此结束,有兴趣的欢迎来尝试交流。也感谢你阅读到这里,如果此文对你有帮助,欢迎转发点赞。

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)