参考资料

核心技术

视频压缩网络

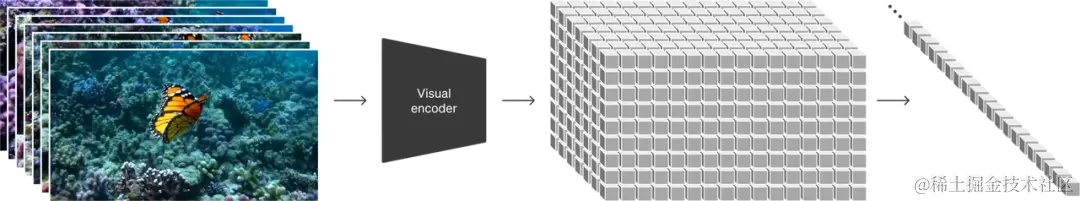

OpenAI 开发了一个新网络,这个网络的作用是将视频数据简化,使得视频可以在更小的空间上保存。它的工作原理是先接收原始视频作为输入,然后将这些视频转换成一种更加紧凑的表示形式,这种形式在时间和空间上都很节省。接着,Sora 在这个缩小的表示空间上进行训练,以便之后能够根据这些信息生成新的视频内容。

为了能够从这些简化的表示中重新创造出视频,OpenAI 还训练了一个额外的模型,这个模型的任务是将这些潜在的表示转换回视频的原始像素形式。这个想法是受到了大语言模型的启发,大语言模型能够处理不同类型的文本信息,如代码和数学公式,并将它们转换成统一的文本“tokens”。类似地,Sora 使用的是视觉“patches”,这些“patches”是从视频中提取的小块信息。

之前 OpenAI 的 Clip 等研究已经证明了将视觉数据分割成小块是一种有效的处理方法。现在,他们在视频压缩网络的工作中进一步探索了这个想法,将高维度的视频数据转换成“patches”,首先把视频压缩到一个低维的“latent space”,然后将视频分成时空上的“patches”。简而言之,就是通过这种方式,OpenAI 能够更高效地处理和存储视频信息。

技术难点

视频压缩网络在某种程度上可以类比于latent diffusion model中的变分自编码器(VAE)。变分自编码器是用来学习数据的潜在表示,并且可以用来压缩数据,使得这些数据可以以更小的大小存储。类似地,视频压缩网络也是用来压缩视频数据的。

然而,这里提到的“压缩率”指的是视频数据在压缩后所占空间的大小与原始视频数据大小之间的比例。目前,视频压缩网络的具体压缩率还没有一个固定的标准,因为这取决于模型的设计、训练以及压缩的算法等因素。

为了保证视频特征在压缩过程中被更好地保留,研究人员需要探索更先进的压缩技术和算法,这可能包括改进模型结构、优化训练过程以及采用更高效的编码方法等。这些研究工作还在进行中,目的是找到一种能够在压缩视频的同时尽可能保留视频质量的方法。

用于视频生成的Scaling Transformers

Sora 是一个扩散模型,它的任务是接收一些带有噪声的视频块和一段文本提示,然后预测出这些视频块原本清晰的样子。值得注意的是,Sora 是基于扩展性强的 Transformers 模型构建的。Transformers 模型在大语言模型领域表现出了强大的扩展能力,因此 OpenAI 认为他们可以将在大语言模型上使用的很多技术和方法应用到 Sora 上。

在 Sora 的研究中,OpenAI 发现扩散 Transformers 模型非常适合用来生成视频内容,并且这种模型具有很好的扩展性,可以处理越来越大的视频数据和更复杂的生成任务。

技术难点

要训练出一个能够扩展的 Transformer 模型,首先需要对视频数据进行有效的处理,将其转换成小块(patches)。这个过程可能会遇到一些挑战,比如如何让模型能够处理长达一分钟的长时间视频语境(long context),如何在视频处理的过程中减少误差累积(error accumulation),以及如何保证视频中物体的质量和一致性。

此外,Transformer 模型需要能够同时处理多种类型的数据,比如视频(video)、图像(image)和文本(text),这就是所谓的多模态支持。这意味着模型需要能够理解这些不同模态之间的联系,并利用这些信息来生成更加准确和连贯的视频内容。总的来说,训练一个能够扩展的 Transformer 模型,需要解决这些技术难题,确保模型能够高效地处理视频数据,并生成高质量的视频内容。

语言理解

OpenAI 发现,要训练一个能够将文本转化为视频的生成系统,需要大量的带有相应文本标题的视频数据。因此,OpenAI 将 DALL·E 3 中使用的标题生成技术应用到了视频领域,训练了一个能够生成高度描述性视频标题的模型。这个模型为所有的视频数据生成了高质量的文本标题,然后将这些视频和它们的高质量标题作为视频文本对一起用于训练。这样的高质量训练数据确保了文本(prompt)和视频数据之间的高度匹配。

在生成阶段,Sora 会使用 OpenAI 的 GPT 模型对用户提供的文本 prompt 进行优化改写,生成既高质量又具有良好的描述性的新 prompt。然后,这个改进后的 prompt 被送入视频生成模型,以完成视频的生成过程。

技术难点 要训练一个高质量的视频标题(caption)生成模型,需要大量的、高质量的视频数据。这些数据不仅需要覆盖各种类型的视频内容,如电影、纪录片、游戏、由3D引擎渲染的视频等,还需要确保数据的多样性和通用性。

在数据准备过程中,包括数据的收集和标注两个重要步骤。标注工作涉及到对长视频进行精确的切片,以便模型能够针对每个视频片段生成准确的标题。这意味着标注人员需要仔细观看视频,并为每个片段提供精确的描述。

由于高质量视频数据在中国一直是一个稀缺资源,随着国内短视频业务的发展,这种情况可能会得到改善。短视频平台的兴起可能会加速中文高质量短视频内容的收集和获取,这些内容可以用于训练视频标题生成模型,从而提高模型的性能和准确性。

世界模型,涌现的模拟能力

这段描述提到了大规模训练时 Sora 模型展现出的“涌现的模拟能力”,这些能力使得 Sora 能够模拟物理世界中的人、动物和环境的一些方面。这些能力并不是由模型中明确定义的三维物体特征或其他归纳特征所驱动的,而是更多是由模型参数的规模和复杂性所带来的涌现现象。

具体来说,Sora 展现出的能力包括:

-

三维一致性:Sora 能够生成带有动态摄像机移动的视频,人物和场景元素在三维空间中会随着摄像机的移动和旋转而一致地移动。

-

长距离连贯性和物体持久性:在视频生成中,保持时间上的连续性是一个挑战。Sora 能够在人物、动物或物体被遮挡或离开画面时仍然保持它们的存在,并在单个样本中生成同一角色的多个镜头,贯穿视频始终保持他们的外观。

-

与世界互动:Sora 能够模拟一些简单的行为,如画家在画布上留下新的笔触,这些笔触会随着时间的推移而持续存在,或者一个人吃汉堡并留下咬痕。

-

模拟数字世界:Sora 也能够模拟人工过程,例如在视频游戏中。它可以通过基本的策略控制《Minecraft》中的玩家,并以高保真度渲染世界及其动态。 这些能力表明,如果 Sora 模型继续扩大规模和改进,它有潜力成为一个能够高度模拟物理和数字世界的模拟器。这意味着未来可能出现如同科幻电影《黑客帝国》中那样的高度逼真的虚拟现实世界。随着技术的进步,这些曾经只存在于科幻作品中的场景可能不再遥远。

技术难点

“大”模型,“高”算力,“海量”数据

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)