OpenAI 团队推出了 Sora,这是一种大规模视频生成模型,它展示了模拟物理世界基本方面的新功能。从GTP-4更加智能后,就一直在关注文本到视频的生成,这个模型代表了质量方面的阶跃函数改进

(twitter上 100% 人工智能生成的视频)

我还在 Reddit 和 Twitter 上看到了很多关于这个模型如何工作的猜测,当这种开创性的东西发布时,很多人都希望想根据已发布视频的Demo中的微妙线索和伪影来推断实现方法,制造信息差来卖自己的产品,twitter上Jim Fan 博士发推说: “Sora 是一个数据驱动的物理引擎”,该帖子在 Twitter 上的浏览量约为 400 万次(但其实它根本不是一个数据驱动的物理引擎)。

后来OpenAI发布了一篇研究文章解释了他们的模型架构,因此如果我们认真的阅读了他们所写的内容,无需付费也能理解OpenAI生成视频的模型原理(如下图)。在本文中,我将引导您了解 OpenAI 团队提供的内容,以便我们了解 Sora 的实际工作原理。

为什么 Sora 很重要

自该领域诞生以来,创建能够建模、理解和模拟现实世界内在复杂性的人工智能一直是一项极其艰巨的挑战。与静态图像不同,视频本质上涉及了表示随时间的变化、3D 空间、物理交互、对象的连续性等等。过去的视频生成模型一直难以处理不同的视频时长、分辨率和摄像机角度。更重要的是,这些系统缺乏对现实进行高保真模拟所需的物理、因果关系和物体持久性的内在“理解”(例如史密斯吃面)。

OpenAI 发布的视频定性地展示了一个比我们在这些领域见过的任何模型都表现更好的模型。说实话,这些视频看起来和真的没区别。例如,一个人在行走时,头部遮挡一个广告牌,然后走出广告牌范围时,标牌上的文字会保持原来的样子。风中的花瓣会随着微风而去。大多数视频模型都无法应对这种挑战,其生成的结果往往是一些闪烁且紧凑的的混乱背景,但Sora却没有,处理的结果非常完美,对比下来更能体现出Sora的重要意义,我认为Sora很重要,是划时代产品,我们可以根据他做出很多有创意性的应用实例,并可能以此进行盈利。

有关模型架构和训练的技术细节

在研究模型和可用帖子时,这项工作建立在 OpenAI 之前的语言模型工作(例如 GPT 系列)的基础上。

Sora 创新点

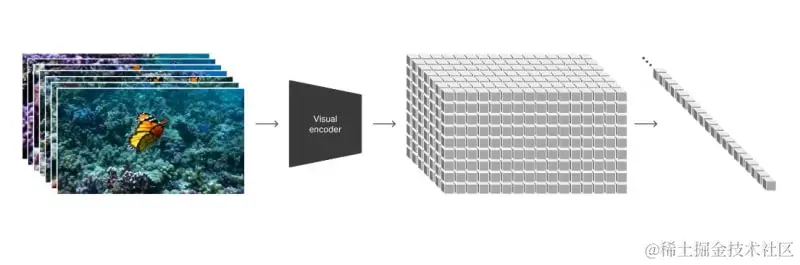

研究人员引入的一项关键创新是 Sora 在训练期间如何表示视频。每个帧都分为许多小块,类似于 GPT-4 等大型语言模型中单词被分解为标记的方式。这种基于补丁的方法让 Sora 可以训练长度、分辨率、方向和纵横比差异很大的视频。无论源视频的原始形状如何,从帧中提取的补丁都会以完全相同的方式处理。

“在高层次上,我们首先将视频压缩到低维潜在空间19 ,然后将表示分解为时空补丁,从而将视频转换为补丁。” – 来自 OpenAI 研究帖子

模型架构

Sora 使用与其 GPT 模型密切相关的变压器架构来处理这些视频补丁令牌的长序列。Transformer 包含时空自注意力层,这些层在对文本、音频和视频等序列中的远程依赖关系进行建模方面显示出巨大的优势。

在训练期间,Sora 的 Transformer 模型将扩散过程早期的视频补丁标记序列作为输入,并预测原始的“去噪”标记。通过对数百万个不同视频进行训练,Sora 慢慢学习了自然视频帧的模式和语义。

文本调节

Sora也是有条件的执行,这意味着它可以根据文本提示可控地生成视频。文本提示被嵌入并作为与当前视频帧对应的补丁一起提供给模型的附加上下文。

为了更好地将文本描述与实际视频内容联系起来,研究人员对从单独的字幕模型生成的每个训练视频使用高度描述性的字幕。这项技术可以帮助 Sora 更严格地遵循文本提示。

推理过程

在推理过程中,Sora 从纯噪声块开始,经过 50 多个扩散步骤反复对其进行去噪,直到出现连贯的视频。通过提供不同的文本提示,Sora 可以生成与标题适当匹配的不同视频。

基于补丁的表示允许 Sora 在测试时处理任何分辨率、持续时间和方向,只需在开始扩散过程之前将补丁排列为所需的形状即可。

功能和限制

通过将训练数据扩展到数百万个视频剪辑并使用大量计算资源,OpenAI 团队发现了一些非常有趣的突发行为:

- Sora 不仅可以将文本转换为视频,还可以从输入图像或其他视频生成视频。

- Sora 似乎对 3D 场景有很强的“理解力”,角色和物体以连续的方式真实地移动。这纯粹是从数据规模中产生的,没有任何显式的 3D 建模或图形代码。

- 该模型显示对象持久性,通常会跟踪实体和对象,即使它们暂时离开框架或被遮挡。

- Sora 展示了模拟一些基本世界交互的能力 – 例如,数字画家在画布上留下的笔画随着时间的推移准确地保留下来。

- 它还可以令人信服地生成复杂的虚拟世界和游戏,例如《我的世界》。Sora 可以在渲染场景的同时控制代理在生成的环境中移动。

- 通过额外的计算和数据,视频质量、连贯性和对提示的遵守程度得到了显着改善,这表明规模化带来了进一步的收益。

但是,Sora 仍然存在重大缺陷和局限性:

- 它经常难以准确地模拟更复杂的现实世界物理交互、动态和因果关系。简单的物理和物体属性仍然具有挑战性。例如,玻璃杯被打翻并溢出,显示玻璃融化到桌子上,并且液体从玻璃侧面跳跃,而没有任何破碎效果。

- 该模型往往会自发地生成意想不到的对象或实体,尤其是在拥挤或杂乱的场景中。

- 当许多动作发生时,索拉很容易混淆左右或随着时间的推移事件的精确顺序。

- 对多个角色和环境之间自然互动的真实模拟仍然很困难。例如,它会生成一个人在跑步机上以错误的方向行走。

未来发展方向

尽管存在缺陷,但随着研究人员继续扩大视频生成模型的规模,Sora 的未来充满了潜力。当有了足够的数据和计算,视频转换器可能会开始对现实世界的物理、因果关系和物体持久性有更内在的理解。与语言理解相结合,这可以实现通过基于视频的世界模拟来训练人工智能系统的新方法。

Sora 为实现这一目标采取了一些初步措施。虽然还需要做更多的工作来解决其许多弱点,但它所展示的新兴能力凸显了该研究方向的前景。在海量不同视频数据集上训练的巨大变压器最终可能会产生人工智能系统,能够智能地与我们的物理环境交互并理解其内在的复杂性、丰富性和深度。

结论

因此,与网上一些毫无根据的说法相反,Sora 不是通过游戏引擎或“数据驱动的物理引擎”来运行,而是通过变压器架构来运行,该架构以类似于 GPT-4 对文本标记的运行方式对视频“补丁”进行运行。它擅长创建视频,展示对深度、对象持久性和自然动态的理解,主要是作为一系列新兴的缩放属性。

该模型的关键创新在于将视频帧视为补丁序列,类似于语言模型中的单词标记,使其能够有效管理不同的视频方面。这种方法与文本条件生成相结合,使 Sora 能够根据文本提示生成上下文相关且视觉连贯的视频。

尽管具有突破性的功能,Sora 仍然存在局限性,例如对复杂的交互进行建模以及在动态场景中保持一致性。这些限制凸显了进一步研究的必要性,但并没有减损其在推进视频生成技术方面取得的重大成就。

最后,我希望 Sora 能够尽快发布,因为我已经能想像到这种技术所带来的冲击,打破了某些层面上的壁垒!

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)