引言

自2022年底ChatGPT-3.5发布起,生成式AI(Generative AI)的话题热度持续走高。 该技术并非只停留于概念阶段 ,而是已开始加速影响着各行各业 ,无论是技术本身还是应 用演进的速度均十分惊人 。银行业本就是最早应用传统人工智能技术的领域之一 ,如何借力新技术 、加速数智化转型 ,构建差异化竞争力 ,是领导层当下必须深入思考的命题 。

对银行而言 ,生成式AI技术与传统AI技术到底有何不同?生成式AI能否为经营管理带来新的价值释放场景? 如何推动场景快速落地? 规模化应用又需做哪些准备工作?本文章将呈现我们对相关问题的思考和建议 。

变革已至,理解生成式AI的能力

直观理解:生成式AI带来哪些不同?

让我们来畅想一下 ,一家银行的零售理财客户经理小王的一天 。

今天是小王入行整五年的日子 。早晨到支行后 ,小王做的第一件事情便是打开最 近部门新安装的 AI 助手——小智 ,开始在对话框中录入问题 。

“小智 ,请打开我今天上午的计划表 。”

“好的 ,小王 。这是今天上午的计划表 ,你计划给三个客户打电话 ,这是预约的 时间和他们的电话号码 。”

今天要沟通的第一个客户是张女士,印象中这位客户小王迄今为止只联系过一 次 ,并不太熟悉 ,于是他在系统中勾选了“查找前期通话记录文稿和微信聊天记录” 和“查找行内交易数据”两个选项 ,并在对话框中连续问了三个问题 ,“小智 ,我上 次与她联系是什么时候 ?她目前都持有什么投资 ?最近是否在本行买卖过产品 ?”

系统只用了两到三秒就给每个问题提供了快速 、准确的回答:“根据记录 ,你上 次联系她是一个月零三天前 。她最近一个月没有交易过任何产品 。目前她的持仓只有 两笔定期理财 。”

小王继续在系统勾选“查找前期通话记录文稿和微信聊天记录”,问道:“小智 , 她之前联系时表示对什么产品有兴趣 ?”

“她表示过对债券型基金和混合型基金有兴趣”,系统很快回答 。

“那上次是否有给她推荐债券型或混合型基金产品?她为什么没买?”小王让 小智继续在前期通话记录中找答案 。

“上次推荐产品时 ,她表示没有闲钱 ,将在一个月之后有奖金入账 ,会考虑进行 配 置 。”

那现在不正是推荐的好时候 ,小王心想 。于是 ,他立刻勾选了“产品推荐引擎”选 项,继续问道,“小智,目前本行在售的混合型基金中,哪款比较匹配张女士的偏好?”

几秒钟之后 ,小智给出了三个答案 ,“根据模型的预测 ,目前有三款产品 ,分别 是 AAA 、BBB 、CCC 三只基金 ,较为适合张女士 。”

小王想起来 ,CCC 这只基金昨天刚开始发售 ,但他还没有时间仔细学习该款产品 的文件资料 ,他于是赶紧勾选了“产品介绍”选项 。对话框中立刻调出了该产品长达 10 页的详细介绍 。

由于没有时间仔细阅读这个冗长的 PDF 文件 ,小王随即勾选了“产品比较”选项 , 问道 ,“小智 ,请用一段文字总结这款产品的主要亮点 ,并跟 BBB 基金进行比较 。” 很快,小智在对话框中返回了CCC基金的三个亮点,以及与BBB基金的两个主要差异。

通过这段一到两分钟与小智的对话 ,小王认为自己已经准备好 ,于是拨通了张女 士的电话 ,开始营销 。通话很顺利 ,张女士表示自己恰巧在选择混合型基金产品 ,并 对小王的推荐和专业的介绍话术感到满意 。在通话期间 ,当张女士好奇问到另外一款 DDD 产品为什么表现不好 ,小王在对话框中同步将问题抛给小智 ,也得到了一段比 较扎实 、多角度的市场分析解释 ,及时传递给张女士 。

下午四点半,小王在助手小智的帮助下,比计划提前完成了今天六个客户的沟 通 ,均取得了较好的营销进展 。本想休息片刻 ,去学习一下市场动态 ,结果领导过来 布置了一个紧急的客户分析任务 ,并要求在下班前提交报告 。原来 ,最近支行财富中 收业绩有所下滑 ,领导让小王这个团队长分析他所在的小组共同覆盖的 AuM 在 300 万 到 600 万的客户近期在产品交易上的变化趋势 。

“幸好现在不用找人帮忙去系统找数 、拉数了 ,也不用自己在 Excel 搞透视表了 , 否则今天下班前怎么可能交得了……”小王一边心里嘀咕,一边再次打开系统对话 框,勾选了“客户数据分析”选项,开始一步步盘问小智,“小智,请把ABCDEF这 六位客户经理所管户的 AuM 在 300 万到 600 万的客户都找到 。”“这些客户过去一个 月的日均 AuM 变化如何 ?”“这些客户在一个月前的合计产品持仓分布发生了什么 变化 ?”“非存 AuM 下滑最快的客户画像是什么 ?”“主要退出的产品的市场表现 有何变化 ?”……一步步地 ,小王层层深入地对着系统问了十几个问题 。在每一步 , 系统都用几秒钟就返回了相关数据 ,并自动形成了线图 、饼图等形式的图表 ,更直观 地显示数据变化趋势 。最终小王把相关图表集中下载到 Word 文档 ,并让小智基于图 表内容自动形成了初稿总结,最后自己再用半小时完善了整体的分析报告与行动建 议 ,顺利在下班之前交出了报告 。

以上客户经理小王的一天 ,就是 AI 赋能的一个典型示例 。在生成式 AI 出现后 ,这个示 例已不再遥远 。实际上 ,场景中的许多片段目前均已实现了概念验证 。例如 ,让机器从非 结构化的通话记录文稿中 ,快速准确找到相关信息并以问答输出;让机器阅读长篇累牍的 产品或资讯文档 ,自动提炼要点;再比如 ,让机器在自然语言的指示下 ,自己去数据库抓 数和作图,打通Text-to-SQL的最后一公里,实现数据分析和制图的自动化。

从这个例子 ,可以直观地感受到生成式 AI 带来的核心体验的变化:客户经理小王不再 需要到 CRM 系统的层层功能菜单中去逐一查找并手动汇总分散的信息 ,也不需要去逐页阅读海量的通话记录 、产品类文档或市场资讯类资料 ,他甚至不需要熟练掌握各类分析性工 具(比如SQL取数、PPT制图、Excel透视分析等)。由于有小智这个不知疲惫且能开展基 础信息加工分析的助手 ,客户经理小王只需要问“对的问题”,就能高效获得精炼的 、极有 针对性的营销知识和客户洞察 ,以供进一步决策或行动 。生成式 AI 把小王从占用时间的案 头类工作中解放出来 ,使小王可以将时间和精力尽可能多地放在与客户的直接交互上 ,同 时还能体现出较之前更专业的水平 。这就是生成式 AI 的魅力 。

理解根因:什么造就了生成式AI的强大能力?

人工智能已发展多年 ,历经专家模型 、机器学习 、深度学习多个阶段 。今天生成式 AI

之所以火热 ,是因其相较传统 AI ,在“对话”与“创造”两类能力上实现了根本性的突破 。

• 就“对话”能力而言 ,过去的机器在回答问题时往往缺乏对上下文的理解 ,导致答案 相关性较低 ,表达机械化;而如今的生成式 AI 能够理解更长的上下文 ,并进行拟人化 的思考和回答 ,与人类的对话沟通也更自然;

• 在“创造”能力方面 ,以往的机器只能按照预设任务(如分类 、数值预测)输出答案; 而现在,生成式AI能够自动生成自洽的图形、文本甚至代码,具备优秀的内容创作 能力。

那么生成式 AI 背后的大模型 ,又是如何形成了突破性的对话和创造能力 ?这离不开科 学和工程的双重进步 。

一是科学的进步,即算法的突破。AI算法的本质在于特征提取。基于Attention Layer 的 Transformer 技术 ,是一种新的模型架构 ,能更好地提取“全局”特征 ,因此模型的效 果更好。Transformer技术使机器能高效捕捉海量语料中一个个词之间的关系,或者海量 图 片 中 一 个 个 像 素 之 间 的 关 系 , 使 得 大 量 的 知 识( 本 质 上 表 现 为 词 语 之 间 的 关 系 )能 被 封 装 在训练好的模型中 。由于该模型架构强大的能力 ,在 2018 年 Transformer 技术出现后 ,三 分天下的AI应用领域(计算机视觉、语音识别和自然语言处理)逐渐形成大一统趋势。以 前各个领域有一套适配其应用场景的模型架构 ,如今 Transformer 可相对较好地处理各类 场景的问题 。

二是工程的进步,即超大规模的算力和数据的支持。由于基础设施的进步(高算力芯片、 高速网络),模型的训练规模较之前深度学习阶段有了数量级的显著跃升 。深度学习时代 的模型参数通常只有百万量级 ,只能训练几亿级的文本且还需要人工标记;但以 ChatGPT 为例的大模型参数可达 1,750 亿 ,能训练数万亿级的单词文本且预训练不需要人工标记 。 正因为训练的语料和参数在量级上的突飞猛进 ,使大模型体现出的能力远超以前 。同时 , 也因为足够大到能训练和封装几乎全科领域的知识,大模型能表现出很强的“通用性”能 力 ,即一个大模型可以在结合精调后运用到多个完全不同的场景 。

银行业应用场景丰富,价值释放可期

价值创造逻辑:替代人、赋能人

生成式 AI 在银行业的应用 ,从价值创造逻辑上可分为两大类:

一是替代人: 生成式 AI 可以替代人 ,开展大量重复性较高 、简单基础的任务 ,如处理 文本的要素提取 、处理进件 、识别异常项 、生成基础数据分析 、生成标准化内容等 。这能 够释放运营类人力资源 ,实现降本增效 。

部分场景下 ,生成式 AI 还可能取代人 ,催生全新的业务模式 。例如交易撮合的场景 , 由于很多场景的交易要素非结构化 ,且需要多轮交互 ,通常需要人来协助开展撮合 ,但借 助生成式 AI ,未来买卖双方都可能只与 AI 界面进行对话磋商 ,而不再需要人作为中介进行 撮合。

二是赋能人: 利用生成式 AI 的“对话”和“创造”能力 ,可让 AI 成为助手 ,有效放大 关键节点的“人”的产能 ,尤其是客户经理 、财富顾问 、产品经理 、投研经理 、信审经理 、 市场营销人员 、编程开发人员等角色 。本报告开篇赋能客户经理的例子就是一个典型示例 。 一方面 ,通过对话式学习的方式 ,生成式 AI 可以更好地“培训”这些专业人员;另一方面 , 在关键的展业过程中 ,生成式 AI 可以有效整合关键信息及素材 ,助力相关专业岗位的人员 , 更快做出精准有效的判断 ,展现出更有针对性的客户互动技巧 ,或更快速地产出高质量的 交 付 物( 代 码 、 设 计 文 案 、 报 告 等 )。 通过机 器 助 手 的 加 持 , 代 表 银 行 核 心 竞 争 力 环 节 的 单 人产能有望大幅提升 。

赋能人不仅仅是体现在专业内容的形成上 ,还可能体现在基础管理环节 。例如 ,以前 项目开展 PMO 管理 ,需要项目经理每天与多个角色共同开会来对齐进度 ,并维护一张集中 显示进度和问题的大表 。未来 ,借助生成式 AI ,有可能实现由 AI 与各个角色实时开展简单 的对话来交流进度 ,最后由生成式 AI 提炼对话中的要素 ,自动形成项目管理看板并自动识 别和提示风险 。在 AI 的加持下 ,以前一个项目经理只能管理两到三个项目 ,未来可能变成 一个人可同时管理十几个复杂项目 。

价值释放空间:贯穿银行前中后台,规模化降本增效

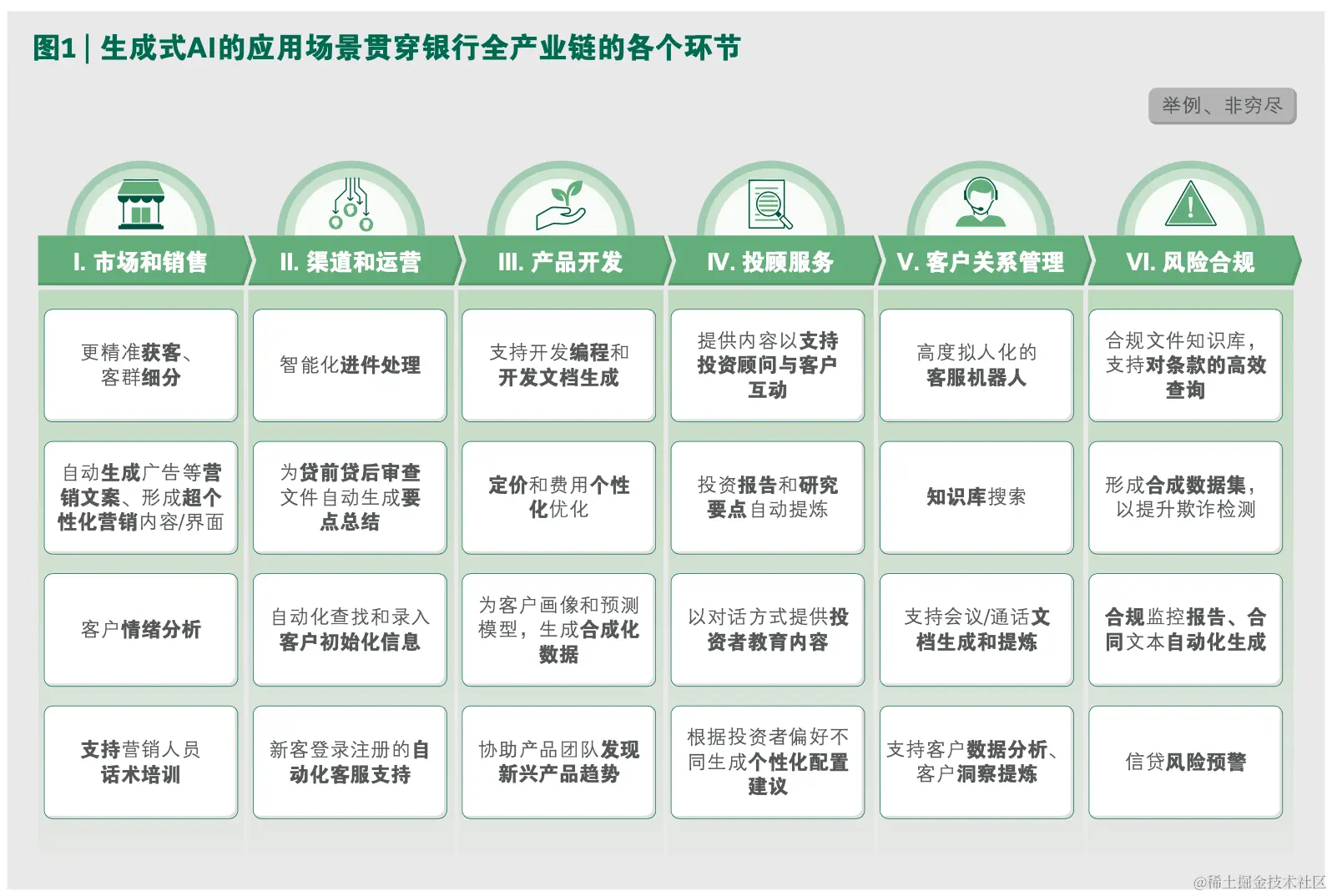

如图 1 所示 ,生成式 AI 在银行业的应用场景可贯穿前中后台各个环节 。银行的每条业 务线 、每个职能 ,都有可能找到生成式 AI 的应用场景 。若能在银行业实现规模化应用 ,有 望带来可观的降本增效收益 。BCG 曾以一家拥有约两万名员工的区域性国际银行为例 ,初 步梳理了该银行前中后台相关部门应用生成式 AI 的潜力和效益 ,预计在首年即可为该银行 节省约 1.5 亿美元的成本 ,占整体薪酬总包的 7% 左右(参阅图 2)。

落地可行:局部速赢已有切实路径,规模化应用还需体系性规划

优选场景:平衡收益和风险,与传统AI充分结合

在应用探索初期 ,各家银行通常优选少量场景先行试水 、循序渐进 。在选择场景时 , 要平衡考量收益潜力 、风险 、实施难度 。同时 ,最早落地的试点场景 ,还需考虑其能否在 组织准备度诊断 、方法构建 、信心构建等角度形成示范效应 。

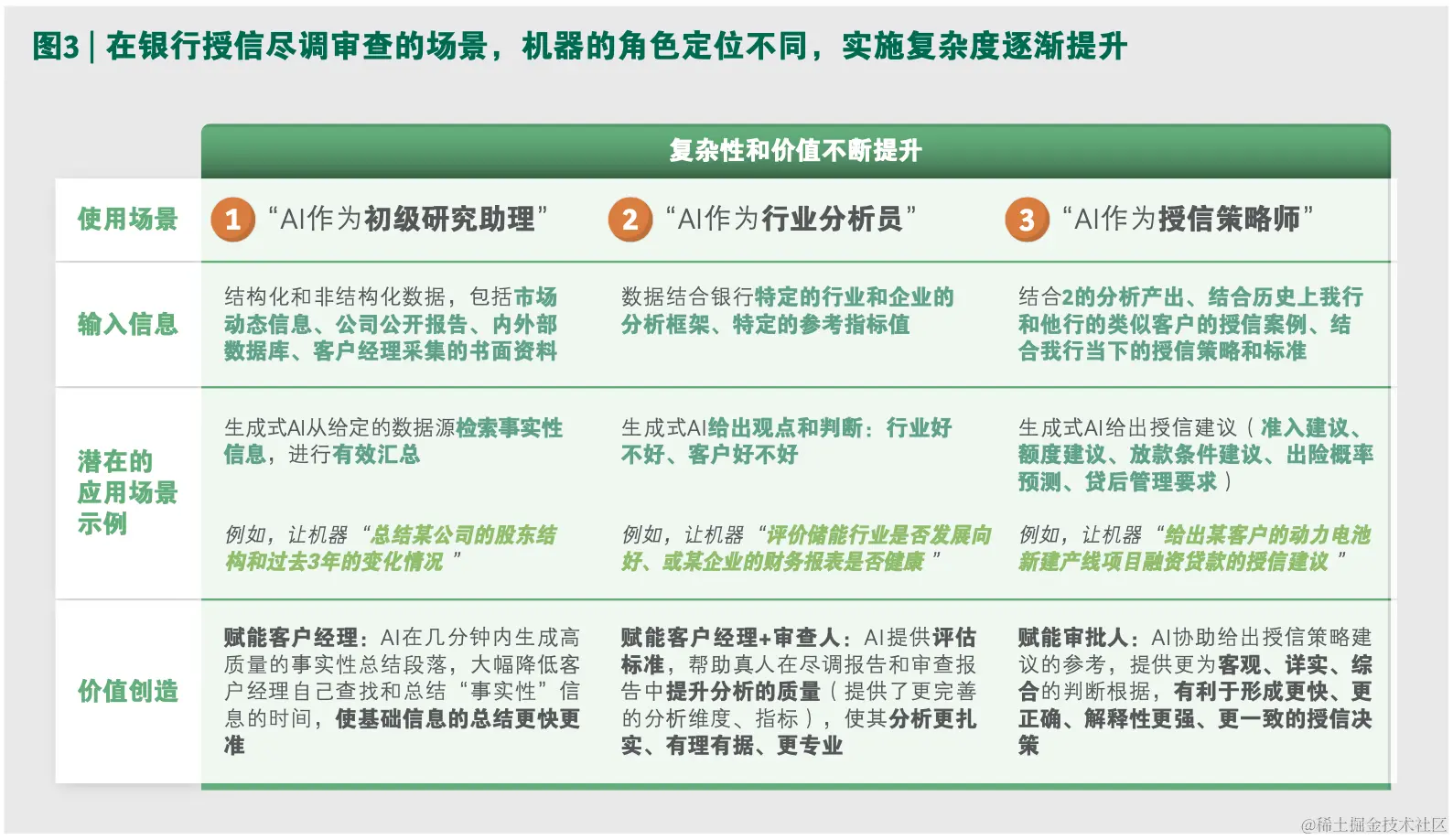

选择场景时 ,不能只是简单定位“业务环节”,粗放地决定到底是应用在财富管理的营 销环节 ,还是应用在公司金融的授信审批环节 。对场景的细分和选择 ,需要具体到机器的 角色和需解决的问题类型 。

以下几个问题 ,是场景定位时通常需面对的权衡选择 。

- 归纳 、分析还是决策 ?

即使是同一个业务场景 ,取决于 AI 的角色定位不同 ,其收益潜力和实施难度也不尽相 同 。以商业银行的授信审查场景为例(参阅图 3),按照角色的要求从易到难 ,AI 的角色可 以是只对事实性信息进行自动抓取和归纳的初级研究助理 ,也可以是对行业和企业到底好 不好能形成严谨分析的分析员 ,甚至有可能成为直接给出某个申报项目到底能否批 、批多 少 、批什么条件的授信策略师 。

最后一种 “授信策略师”显然代表了最高的技术应用水平,但这并不意味着就是当下 优先级最高的必选场景 。一般而言 ,涉及大额交易的复杂投融资决策 ,往往都不是 100% 的 规则导向 、有标准答案的 ,在基于客观 、全面 、深入的理据分析基础上 ,最后的决策往往 还会融入当下团队的经验 、风险偏好 、非经济回报类收益等主观考量因素 ,机器难以捕捉 。 另外 ,机器给出的策略有利于保持每次决策的标准一致性 ,但这种一致性在历史决策并不 明智的情形下(如历史决策数据中可能包含大量由于太过谨慎而错失好机会的例子),反而 可能导致非最优决策的更长期延续 。

反之 ,在前两种角色定位上 ,生成式 AI 的价值释放潜力短期来看可能更为显著 。对公 客户经理团队的专业水平 、学习意愿通常参差不齐 ,在申报授信方案过程中搜集整理客户 及行业的信息也通常需耗费大量时间 。而当下 ,银行的授信要具备竞争力 ,一方面要“快”, 另一方面要“专业”。作为“分析员”的生成式 AI ,可以直接构建基于专业行业分析框架 、 评估标准的初稿 ,大幅减少客户经理自己从 0 到 1 学习理解新行业和加工处理基本信息的 时间 ,客户经理写出的尽调报告的平均水平在短期有望显著提升 。

- 面客还是对内 ?

在对成本收益进行考虑时 ,不仅要考虑直接的运营人力节约的收益 ,还要考虑因潜在

风险可能导致的额外间接成本 。

例如 ,在零售远程银行的业务场景中 ,一种应用模式是让 AI 直接“面客”,让 AI 直接 成为外呼的营销坐席 ,代替真人坐席与客户开展营销互动;而另一种应用模式是对内赋能 , 即 AI 成为营销坐席的助手 ,在真人坐席与客户互动时 ,为其实时提供更详细 、专业的信息 支持 ,或提供“回答草稿”,最终仍由真人坐席来把握实际对话内容 。前者相较后者 ,看似 直接节约运营成本的效果更加显著 ,但可能因 AI 互动质量的不确定性 ,导致部分客户体验 不佳 、反而投诉增加 。

由于银行业在开展对个人客户的销售时 ,往往较其它行业面对更严格的行为监管和内 控要求 ,在“面客”场景首先试水生成式 AI ,实际挑战可能更大 。

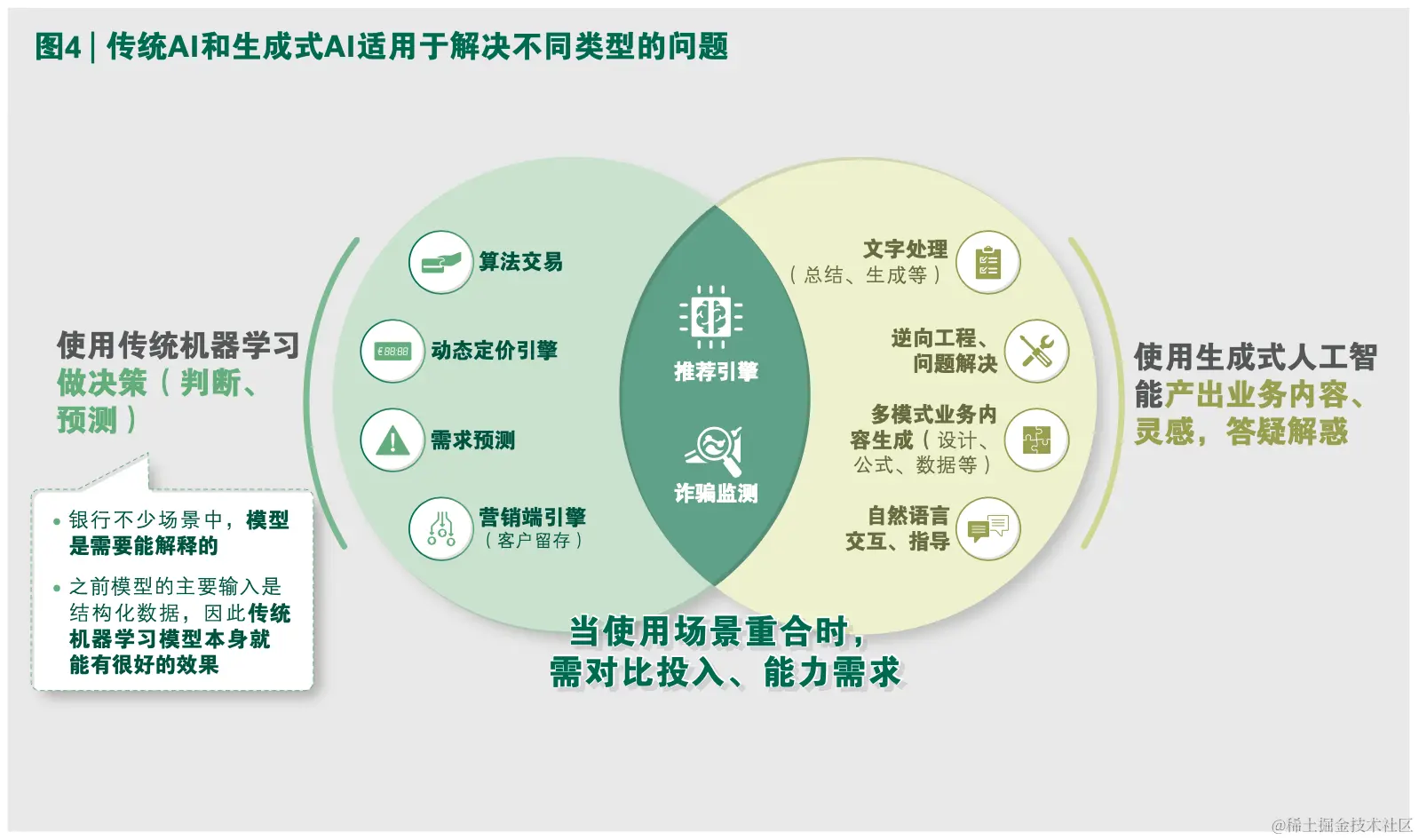

- 对目前已在应用的传统 AI ,替代还是结合 ?

在大模型出现之前 ,银行已有非常多的传统 AI 模型的应用 ,例如 ,在线上小额个人贷 款领域由机器实现智能放贷 ,或由机器生成理财产品推荐建议 ,或由机器判定高潜获客名 单或客户流失率 。既然 Transformer 技术有大一统趋势 ,且支持多种任务类型 ,那是不是 意味着 ,所有传统 AI 模型的应用场景 ,都需要用大模型来重新做一遍呢 ?

并非如此 。实际上 ,传统 AI 模型在不少场景已体现出很强的能力 ,其与大模型在相当 长一段时间内会共存 。如图 4 所示 ,两者适配解决的问题类型并不相同 。从单一任务来看 , 传统机器学习模型较为擅长的是需要较强解释性 、需要进行量化预测结果的任务 。而大模 型擅长的是产出业务内容 、答疑解惑式场景的任务 。

未来 ,大模型和传统的单任务模型之间 ,更可能是强强结合 、同时使用的关系 。

两者间可能是总分关系:大模型有望成为问题解决的中枢“大脑”。通过大模型 ,可将 一个相对复杂的问题拆解成不同的步骤 ,每个步骤去调用不同的单一任务传统模型 ,最后 大模型再将不同单任务模型的输出进行串联整合 。以前 ,业务流程的数字化往往体现在单 一任务上的数字化 ,但连接不同活动的流程仍需要人的相当介入 。在大模型的帮助下 ,未 来人们可以利用自然语言 ,将长线的目标任务拆解思路教给有推理能力的机器 ,然后由机 器来完成一个完整业务问题的全流程数字化 ,使得业务流程数字化从“任务数字化”进阶 到“目标智能化”。

两者间还有可能是串联关系:针对特定任务 ,传统 AI 和生成式 AI 的串联使用可进一 步提升预测的准确性 。例如 ,在金融反欺诈场景下 ,大模型可以通过创建额外的合成数据 点 ,来解决欺诈训练数据稀缺性的问题 。国外银行已有实践表明 ,利用合成数据集 ,传统 AI 反欺诈模型的预测性能会进一步提升 ,误报率会降低 ,甚至还可识别出新的可疑活动类 型 。再比如 ,在个人金融产品的营销推荐场景下 ,大模型可代替人工 、有效读取各类非结构 化 数 据( 如 客 户 谈 话 记 录 ), 自 动 提 炼 为 结 构 化 的 客 户 画 像 标 签 , 动 态 持 续 地 输 入 到 传 统 的产品推荐 AI 模型中 。由于输入的变量更加丰富 、准确 ,模型的推荐结果也能更个性化 、 更精准贴近客户的需求 。

巧用方法:三大抓手,让机器的答案更专业、更实事求是

从0到1训练大模型的成本和难度高企,因此大模型开发能力未来将集中于少数专业 机构 。对银行而言 ,主要的落地路径是直接应用市场上已训练好的大模型 。但拿来即用 , 需有正确的方法来应对两大挑战 ,确保答案质量可靠 。

• 挑战一是 “说真话”: 生成式AI的“知识”是基于预训练时已经封装好的“知 识”,它的知识并不能及时更新,更没有融入各家银行自身掌握的专属数据和信息。 因此,直接与其对话时,给出的答案容易出现偏离事实、甚至“胡说八道”。

• 挑战二是“说专业的话”: 大模型虽然有很强的“泛化”知识能力,但在某些专业领 域的知识并不一定能掌握得好;每家金融机构内部一些特定的表达要求、表达风格在 预训练时也未曾捕捉。

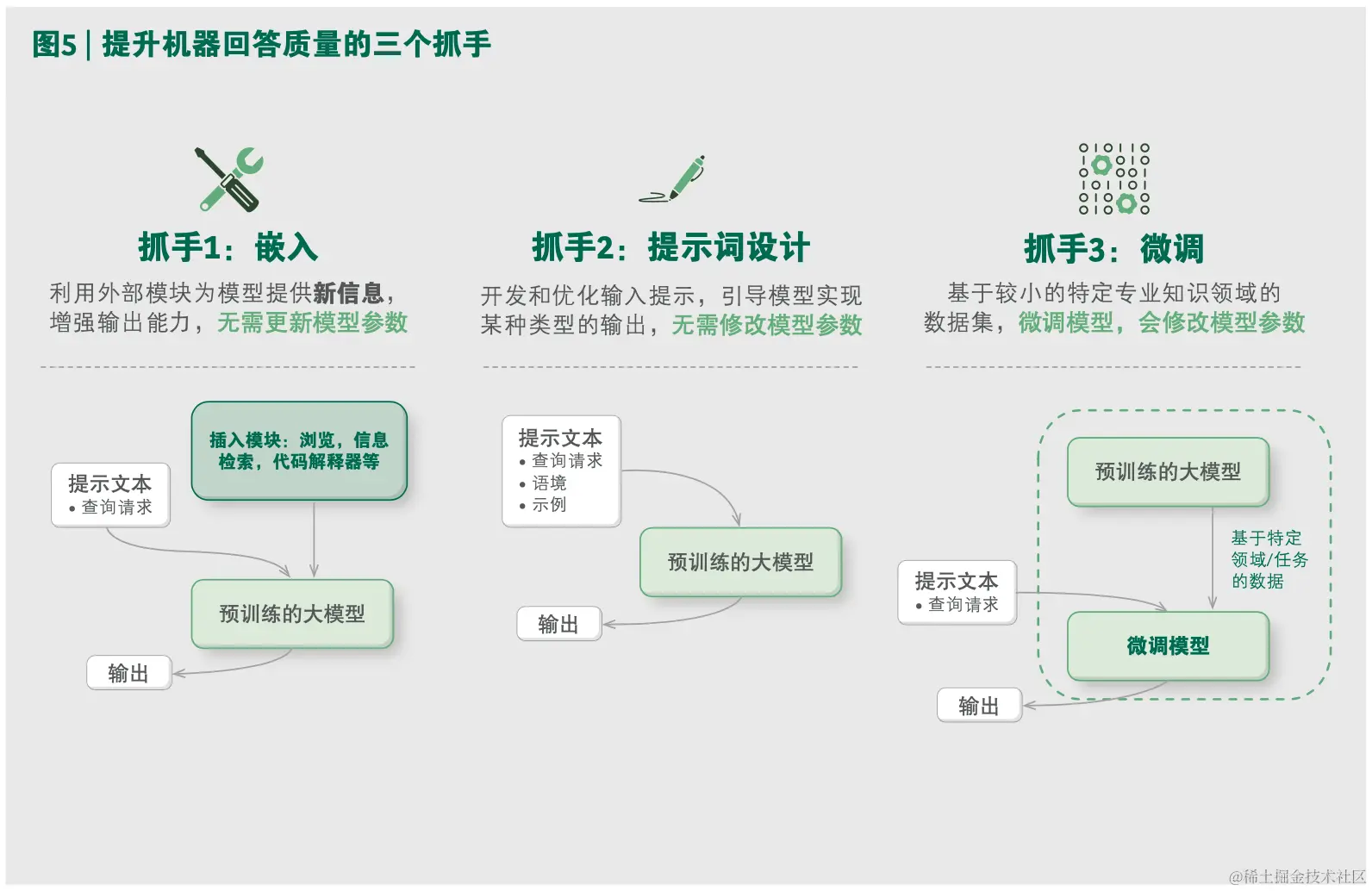

那 么 , 如 何 让 模 型 产 生 的 答 案 更 能 契 合 银 行 自 身 的 需 求 呢 ? 有 三 个 关 键 抓 手( 参 阅 图 5 )。

抓手一:利用嵌入(embedding),使大模型能基于给定的数据库来生成答案 。例如 , 银行可以将理财经理与客户 A 的前期通话访谈记录 、客户 A 在银行渠道的理财产品买卖交 易历史记录 ,都切割编码放入到向量数据库 。当理财经理问系统“客户 A 的理财偏好是什 么?”这个问题时,系统首先到向量数据库检索出相关信息片段(买卖记录中能显示出产 品偏好 、对话记录中也有表示出的产品偏好),之后再将理财经理的问题和搜索到的信息 片段传送给大模型 ,由大模型整合形成最终的对话式答案 。

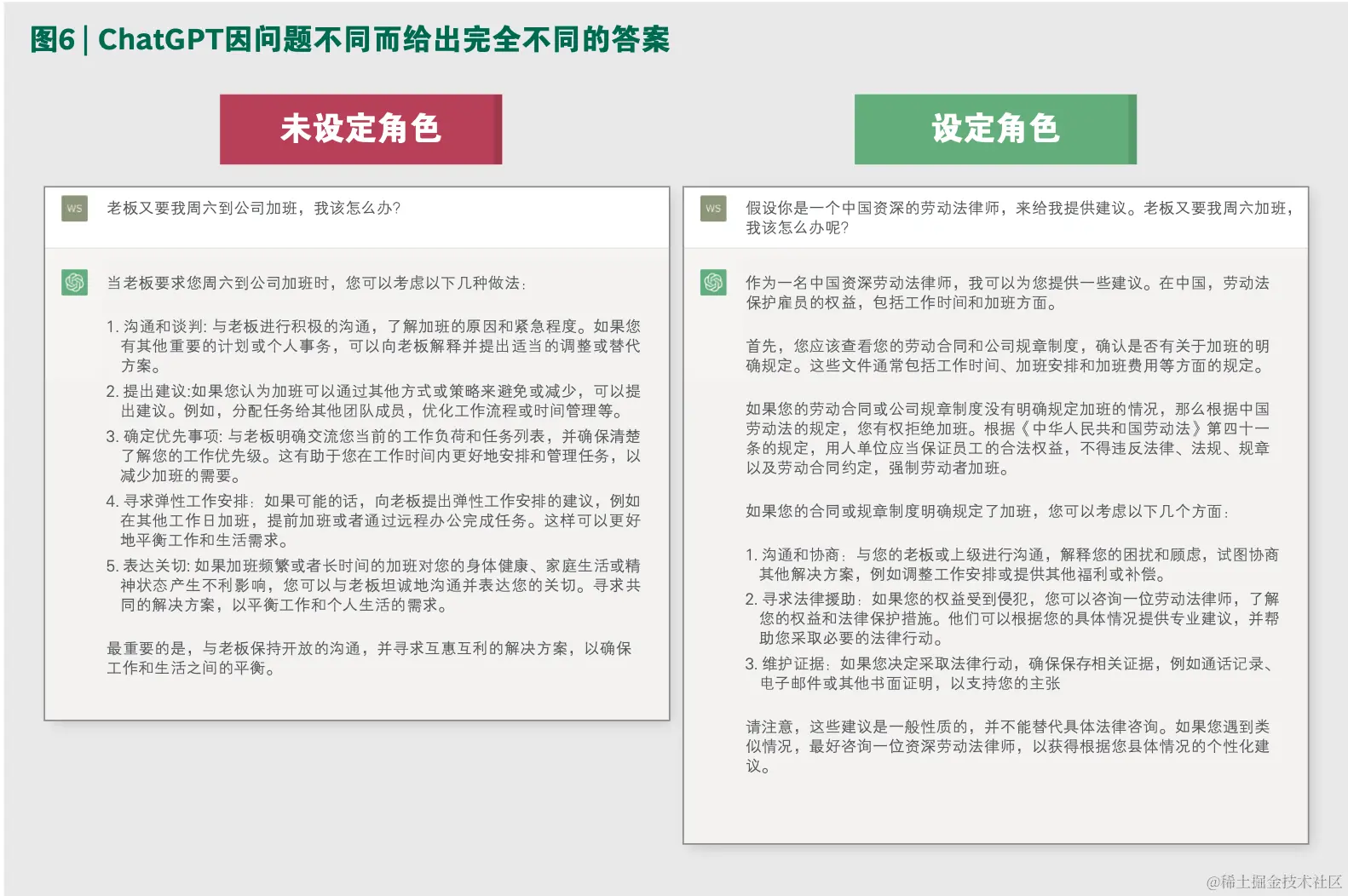

抓手二:利用强有力的提示词设计,使模型给出契合专业性要求的准确答案。问题 怎么问 ,即提示词是什么 ,对模型的输出结果有决定性的影响 。一个简单的例子 ,同样问 ChatGPT“如果我老板让我周六加班 ,我该怎么办 ?”,当加入半句话“请你以一个劳动法 律师的角色来回答”时 ,问题的答案就会完全不同(参阅图 6)。

当然 ,提示词之所以目前已称之为工程 ,甚至一个新学科 ,绝不只是体现在单一问题 上应用角色设定 、提供背景等简单技巧 。在以提示词进行应用开发时 ,可利用 LangChain 把问题解决的长线逻辑和相关例子全部融入进去 ,使大模型能按照预设的步骤 、思考链路 、 回答格式来产生答案 ,从而形成更符合专业领域要求的产出 。目前 ,领先大模型如 GPT-4 的提示词已可以容纳32K(约2万字)的输入,能支持相当复杂的、含多轮“问答对”的问 题描述 。从落地所需的能力来看 ,提示词工程对团队的要求 ,根本上是问题拆解 、流程梳 理的能力 ,对软件开发能力的要求较为有限 。

抓手三:直接对开源大模型进行指令精调 。精调模型会直接修改模型的参数 ,使得模 型在有限提示词下 ,一次性生成答案的质量更高(zero-shot 质量更高)。不过 ,即使模型进 行了精调 ,若要处理的是需拆解多步逻辑链路的问题 ,仍需要在提示词上精心设计 ,只靠 精调模型难以解决所有应用诉求。另外,精调模型需要更多的示例(数量明显多于提示词 设 计 所 需 的 高 质 量 示 例 要 求 , 且 需 要 人 工 标 注 )和 一 定 的 算 力 资 源( 需 高 算 力 芯 片 ), 同 时 还需要团队有擅长做模型的数据科学家 ,这都使得场景应用开发的整体资源投入更高 。

因此 ,若应用方能选择的大模型本身性能足够强大领先 ,且处理的问题需要多步逻辑 拆解 ,通常优先考虑直接用“提示词设计”而非“精调”来进行场景应用的开发 。反之 ,针 对 不 需 复 杂 逻 辑 拆 解 、 相 对 直 接 的 “ 内 容 问 答 ” 类 场 景( 如 客 服 、 知 识 库 、 培 训 等 ), 银 行 通常有大量现成的高质量“问答对”的数据积累可支撑训练 ,那么精调不乏为投入产出比 更高的一种路径 。

夯实技术:合理部署、多维选型、全栈升级

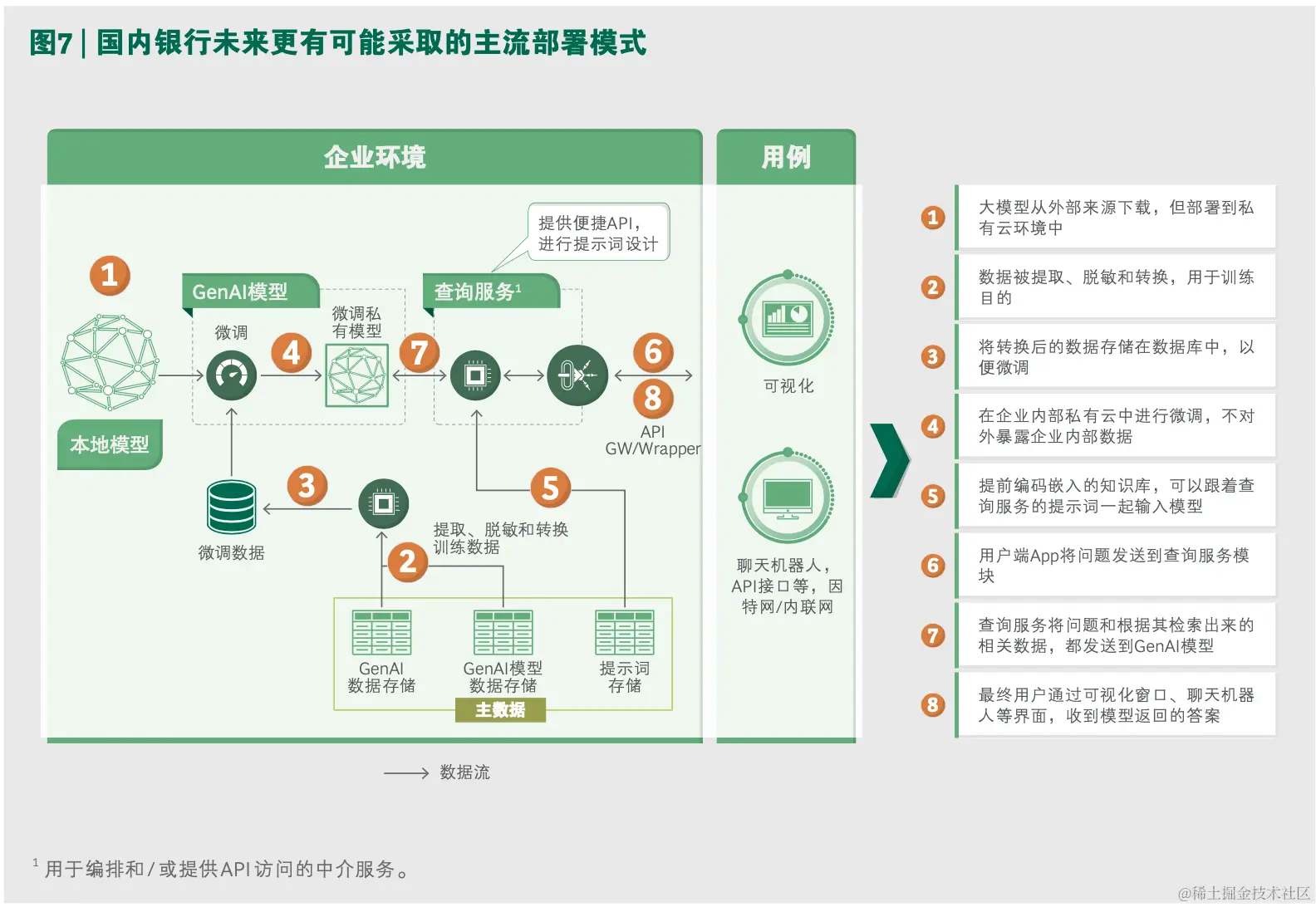

从部署上看 ,银行等金融机构对数据安全性有非常严格的要求 ,这意味着模型的精调 、 模型的应用都很可能需在本地进行 ,保证专属数据“不出行”。图 7 呈现了国内银行未来可 能采取的主流部署模式 。

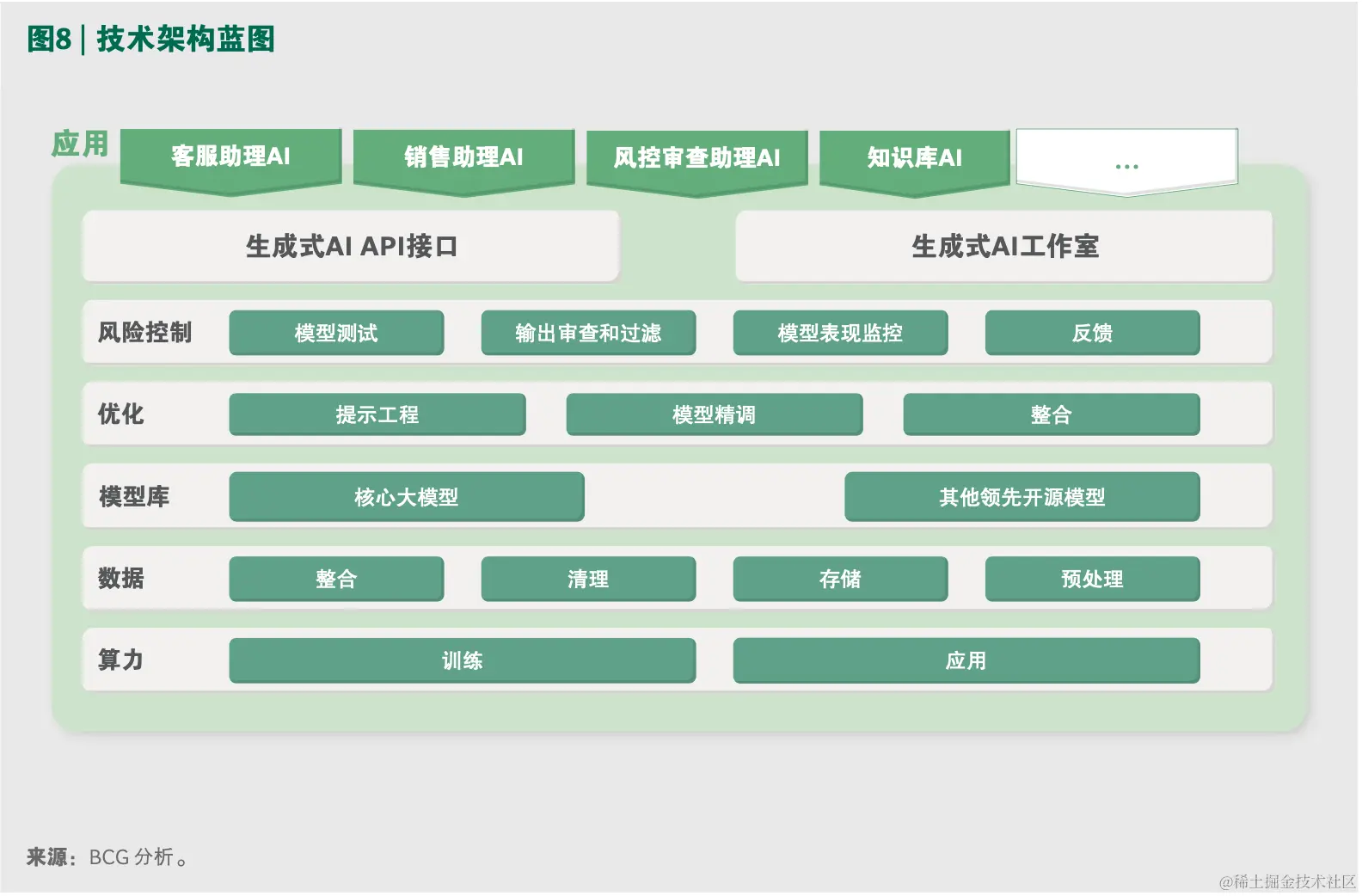

从技术上看 ,若要在全行前中后台都规模化应用大模型 ,多项软硬件能力也需相应升级

(参阅图 8)。

首先是算力 。即使不从 0 到 1 训练大模型 、只是进行精调 ,也需要一定的高算力资源 。 另外 ,若未来有成百上千个 AI 应用同时在组织内运行 ,对硬件基础设施的算力 、稳定性也 提出了更高要求 。

其次是模型。大模型的选型尤为重要,但这并不是一件简单的事情。模型是不是越 “大” 越好?并不一定。比如Meta的LLaMA(2023)模型参数为650亿,比GPT-3(2020)

的 1,750 亿参数量小一个量级 ,但性能却并不比后者差 。训练语料 、训练方法 、训练时长 , 都会对模型效果有影响。另外,近期有斯坦福大学的研究表明,“三个臭皮匠顶一个诸 葛亮”,即在特定场景下 ,三个较小的模型的共同应用可能比一个很大的单一模型的表现 更好。

在具体给某个场景进行模型选型时 ,业务团队的输入很关键 。需要有充分的测试例 , 来验证模型在准确性 、置信度 、鲁棒性 、公平性 、毒性 、效率等多个维度的表现 。针对不 同类型的场景 ,评估前述各个维度的测试例也不尽相同 。除了模型自身的效果表现外 ,模 型的选型还要考虑与平台合作方相关的其它因素 ,例如商用授权的要求 、能否支持精调 、 安全性 、兼容性等 。

从规模化应用来考量 ,未来银行需要引入和维护一个模型库 。如之前所述 ,很多场景 需要大模型和传统 AI 模型的并用 ,因此模型库需要纳入多种模型 。即使是大模型 ,目前各 家开发商仍然处在一个快速迭代 、你追我赶的阶段 ,甚至商用授权等商业模式都在快速变 化(例如7月20日,Meta宣布Llama 2支持免费商用)。因此,银行作为应用方,在现阶段 开展试水时 ,需对大模型的选择保持开放态度 ,可在以一家大模型为主的基础上 ,也仍然 积极尝试市场上其它领先的开源模型 ,持续寻找场景与模型之间的最佳适配组合 。

除了模型选型之外 ,围绕规模化应用开发 ,还需要构建其它多项能力 。

一方面是 3.2 小节中已提到的基于提示词设计进行应用开发的能力 。要发挥出大模型 的应用潜力 、缩短应用开发周期 ,就需要让不具备软件编程能力的业务团队能更加自主 、 充分地开展基于提示词设计的应用开发 ,而这需要搭建一个全部基于自然语言交互 、支持 “托拉拽”的开发工具 ,支持业务人员进行问题拆解 、定义“问答对”。银行未来可以设立 一个生成式 AI 工作室团队 ,专门为业务团队的应用开发搭建工具 、开展培训 。

另外 ,不同场景的提示词设计中的“问答对”是有可能复用的 ,甚至是需要全行有统 一定义 ,才能取得更好的效果 。这些“问答对”的沉淀 、背后的代码管理也需要有相应的 机制 。在初期进行部分典型场景试水时 ,银行的技术团队就要开始思考 ,如何构建常态化 、 针对“提示词设计”开发的研发管理机制 。

另外 ,风险控制也很关键 。如何形成高质量的测试能力 ,如何进行内容审查 ,如何持 续基于应用形成反馈 ,这些方面也都需要构建新的管理流程和标准 。

重塑体系:规模化应用需遵循10/20/70原则,技术之外更关键

我们认为 ,生成式 AI 在银行业规模化应用的落地 ,是一个体系性工程 ,其成功与否会

遵循“10/20/70”法则,即:10%是模型,20%是整体IT能力升级,70%是业务与组织的转型。

当大量运用 AI 时 ,需要有操作行为规范 ,引导员工进行合适的信息输入 、并对机器输 出进行合理地判断和使用 。围绕质量管理 、风险监控 、责任认定等 ,也需构建匹配的管理 机制 。银行还要构建负责任 AI 体系 ,在精调和应用开发时 ,尽力确保公平性 、可靠性 、透 明度或可解释性 、隐私安全 、可问责等目标 。

另外 ,生成式 AI 的大范围应用也将变革企业的岗位和人才结构 ,以及人才的选拔培养 体系 。从人才结构上来看 ,专业技能岗位的基础级别员工的需求量可能会减少 ,而质量管 理岗位的人员需求可能会增加 。从人的能力素质要求来看 ,员工之间专业技术的方差可能 会伴随机器的赋能而变小 ,但是在问题定义能力 、问题解决能力方面的综合要求会比以前 更高 、更能拉开人与人之间的差距 。围绕人才要求的改变 ,企业的人才培训体系 、人才晋 升的路径和标准也都需要相应变化 。

快速行动:银行需由点及面、敏捷推进

生成式 AI 的浪潮已席卷全球 ,国内外诸多金融机构均已开始加速应用场景的探索 。虽 然目前全市场看似兴致很高 ,但很多机构实际还未下定决心 ,热情和动力还只是停留在对 各类“首个应用”名头的跑马圈地 。

各家银行应充分意识到 ,这次的新技术不只是噱头 ,而是有望切实带来革命性生产力 提升的范式变革 。对于生成式 AI 的探索 ,银行需要有长远的眼光 ,开展体系化的顶层规划 , 需要联合相关业务和科技部门协同努力 ,推动规模化应用的分步落地 。

具体而言 ,可分三个阶段 ,由点及面 、敏捷推进:

• 第一阶段,少量场景的概念验证和局部落地:选择重点应用场景,快速完成概念验证 (POC)、构建最小可行性产品(MVP)。利用这一过程,诊断技术、业务两方面的 准备度,梳理出部署模式、技术选型、质量和风险管理的框架标准、及配套的组织及 资源投入要求。

• 第二阶段,开展全场景盘点+体系规划:基于局部应用的效果和经验,形成规模化实 施的顶层规划,包括:盘点银行所有潜在应用场景,基于商业价值和可行性高低,排 布场景的落地先后优先级,形成投入产出量化评估方案;形成技术架构整体升级的细 化方案设计;形成质量和风险管理的体系化方案;形成业务和组织能力转型的方案设 计;形成能力建设关键举措及路线图。

• 第三阶段,规模化应用落地+体系能力固化:完成技术和工具基础设施的搭建;依次 分批推进应用场景落地;围绕业务、技术端不断积累应用经验;持续在落地中迭代问 题,并将相关能力固化至技术架构、业务流程和管理规范中。

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)