👉👉原文链接👈👈

阅读详细图文,可访问知识库

「 行业动态 」

◇ 奥特曼 YC 演讲:“套壳” OpenAI ,注定消亡! 🔗 News

OpenAI CEO 奥特曼在 YC 校友分享会上分享了关于 OpenAI 和 AI 行业的观点。他强调了”套壳”OpenAI 的观点,认为简单包装 OpenAI 的公司不会长久。奥特曼看好 AI 在医学和教育领域的应用,包括 AI 医学顾问和 AI 个性化一对一辅导。奥特曼还透露了下一代大模型 GPT-5 和 GPT-6 的特点,包括多模态输出和更高的可靠性。他认为距离 AGI 还有很长的路要走,AGI 需要能够自行推理和发展新知识。最后提到了 ChatGPT 的起源和 Alec Radford 的贡献,指出他坚持大模型研究改变了 OpenAI 和 AI 领域的发展方向。

◇ Token 变 Voken:MiniGPT-5 带来文本和图像自动生成 🔗 News

加州大学圣克鲁兹分校的研究团队最新发布了创新的多模态生成技术,名为 MiniGPT-5。该技术采用生成式 voken 概念,结合了 Stable Diffusion 机制和大型语言模型,为多模态生成带来了重大突破。MiniGPT-5 经过两阶段训练,无需特定领域的注释。它采用了双损失策略,确保生成的文本和图像协调一致。这项研究为多模态生成打开了新的可能性,表现出色,建立了新的基准,可在多个领域应用中发挥重要作用。

- paper: browse.arxiv.org/pdf/2310.02…

- 项目地址:github.com/eric-ai-lab…

◇ DeepMind 全新 AI 项目曝光:可控制各类机器人 🔗 News

DeepMind 与 33 个研究机构合作推出 Open X-Embodiment 项目,旨在开发通用 AI 系统,可与不同类型的物理机器人协同工作并执行多种任务。该项目引入了包括 22 种机器人类型在内的庞大数据集,并采用具备技能迁移能力的 RT-1-X 模型。这一数据集包含超过 100 万个场景,展示了 500 多种技能和 15 万项任务,是最全面的机器人数据集之一。项目的核心理念是创建通用模型,类似于大型语言模型(LLM),可适用于各种机器人类型。RT-1-X 模型在多种任务上表现出色,成功率高出 50%,并可在不同环境中迁移技能。未来计划将这些进展与 DeepMind 的 RoboCat 模型结合,推动机器人研究的新方向。

◇ 浙江工业大学大三学生开发者的 AI 创业之路 🔗 Twitter

两位年轻的浙江工业大学大三学生创建了 ChatMind AI,类似于 C.AI 的产品,自 3 月启动以来,吸引了 20 万用户并创造了若干万元的收入。他们通过自然流量、KOL 推广和用户自传播成功适应市场,手机端用户占 60%,PC 端用户占 40%。未来规划包括精细场景化需求和满足学生需求,得到了市场和行业的积极反馈,引起了大厂代表和创业者的关注。产品功能包括资深程序猿、写作大师、角色扮演、傲娇姐姐女友、AI 图片生成工具、万能学习助手等,用户情感需求的技术创新也受到强调,强调了快速适应市场和持续探索的重要性。

◇ 2 行代码,「三体」一次读完!打破 LLM 遗忘魔咒 🔗 News

港中文贾佳亚团队与 MIT 合作发布了名为 LongLoRA 的技术,仅需两行代码,显著扩展大型语言模型的文本处理能力,有效解决了长文本处理问题。LongLoRA 技术使得 7B 模型文本长度可扩展到 100k tokens,70B 模型扩展到 32k tokens,填补了大型语言模型在长文本处理方面的不足。LongLoRA 技术通过分组和偏移模拟全局自注意力机制,显著减少了计算开销,相较于全参数微调,它降低了显存消耗和训练时间,成为大语言模型处理长文本的重要突破。

- paper: arxiv.org/abs/2309.12…

- Github: github.com/dvlab-resea…

◇ 美国主导生成式人工智能领域投资 🔗 News

美国主导生成式人工智能领域的投资,占全球 89%的份额,特别是 Stable Diffusion 和 ChatGPT。过去五年 GenAI 领域总投资超过 220 亿美元,2023 年投资持续增加,GenAI 对邻近市场产生冲击,初创公司融资溢价明显,风险投资逐阶段增长,2023 年达到 120 亿美元。模型制造商融资占 GenAI 资金的 60%以上,应用程序和基础设施投资增加。全球生成式人工智能融资最多的国家是美国,中国在 AI 芯片领域处于领先地位。

◇ ChatGPT 与 Bing Chat:应该使用哪个 AI 聊天机器人 ? 🔗 Twitter

选择 ChatGPT 的理由:

- 广泛知名度和流行度:ChatGPT 是 AI 聊天机器人领域的领头羊,备受瞩目,拥有广泛的知名度和流行度。

- 深入回答:ChatGPT 提供最深入的回答,不受查询限制,可以回答多个后续问题。

- 训练历史:ChatGPT 在 2021 年之前训练过,可以回答关于 2021 年之前的事件和主题的问题,包括技术领域如写作和编码。

选择 Bing Chat 的理由:

- 互联网访问权限:Bing Chat 可以访问整个互联网,提供关于当前事件的免费信息,适用于获取最新事件、故事和研究相关的问题。

- 回答来源:Bing Chat 提供回答的来源,有助于确认信息的准确性,特别是在工作或学术交付、研究或休闲对话中。

- 数学问题解答:通过 Bing Chat 提出数学问题将为你提供复杂的数学表达式和它们的来源。

- 访问 GPT-4:如果需要免费访问 OpenAI 的最新模型 GPT-4,Bing AI 是唯一的选择,它在 GPT-4 上运行,比 GPT-3.5 更先进和可靠,并且无需付费订阅即可获得 Bing 的最新功能。

◇ 美图发布自研视觉大模型 MiracleVision 3.0 🔗 News

美图公司在 15 周年生日会上发布了 AI 视觉大模型 MiracleVision 3.0 版本,仅 100 天内取得显著进展。这一模型具有出色的图像细节生成能力,核心特性包括智能联想和精准控制,将在电商、广告、游戏、动漫、影视等五大行业中应用,提高工作效率和美学水平。创始人吴欣鸿认为,AI 视觉大模型将在未来几年内成熟,成为创意库,为不同应用提供技术支持和效果迭代。这一事件标志着美图公司在 AI 视觉领域取得重大进展,将在多个行业中发挥关键作用。

◇ 为什么 RAG 如此受欢迎? 🔗 Twitter

RAG 的受欢迎程度源于其独特的优势和成本效益的结合,它将“封闭书籍”方法的生成灵活性与“开放书籍”检索式方法的性能相融合。

RAG 的优势:

- 动态知识控制:RAG 允许在不重新训练整个模型的情况下轻松修改和补充内部知识,节省时间和资源。

- 当前和可靠信息:RAG 确保模型始终可以访问最新和可信的事实数据。

- 透明的来源验证:用户可以通过查看模型的信息来源来验证其输出,提高对模型输出的信任度。

- 信息泄漏减少:RAG 的基础是外部可验证的事实,从而降低了模型泄漏敏感数据或生成不准确信息的风险。

- 领域特定知识:RAG 可以提供关于内部数据的额外上下文和信息,以更好地满足特定领域的需求。

- 成本效益和低维护成本:RAG 降低了企业使用大型语言模型的持续培训和参数更新成本,带来了更经济高效的解决方案。

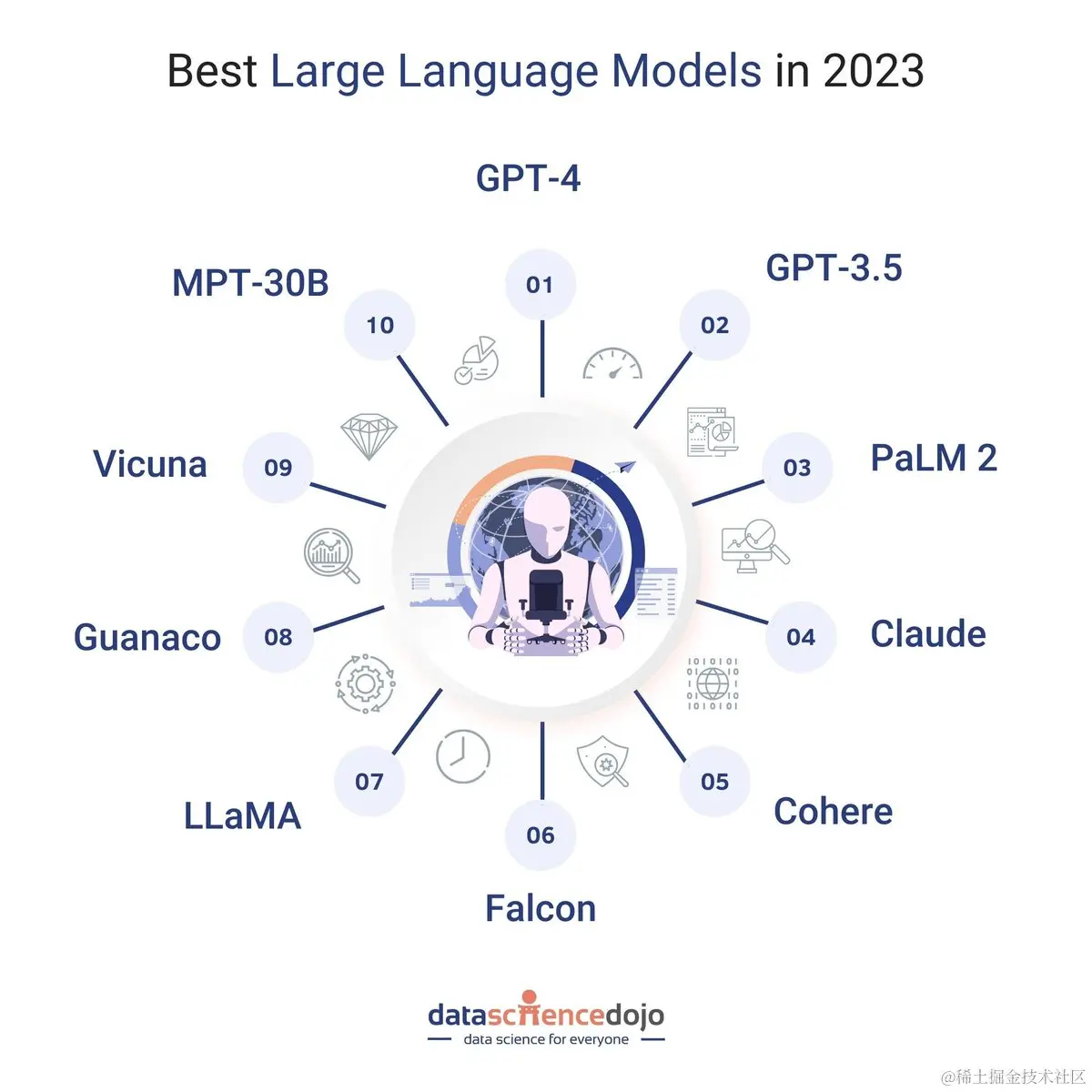

◇ 2023 年最佳大型语言模型! 🔗 Twitter

◇ 如何培养下一代 AI 人才 🔗 Twitter

建立人工智能人才和项目管道需要技术和教育的支持,政府和基层倡议的参与至关重要。全球范围内的人工智能中心,如波士顿、硅谷、多伦多等,依托卓越的学府和科学顾问,吸引了全球人才。培养具备人工智能能力的工人是解决人工智能问题的关键,而美国在人工智能领域的领先地位需要支持下一代人才的培养。各国政府应该为基层人工智能生态系统提供支持,包括在教育中认可人工智能学位。建立本地化的人工智能生态系统和卓越中心是培养下一代人工智能人才的关键,需要合作、建立信任,解决当地问题,以推动人工智能领域的领先地位。

◇ 美国国家安全局的新人工智能中心 🔗 News

美国国家安全局成立人工智能安全中心,保护人工智能系统免受错误、漏洞和外国情报威胁,并维护美国在人工智能领域的领先地位。美国政府附属部门长期思考人工智能及其影响,地缘政治紧张局势可能受人工智能技术影响,而灰色世界持续关注人工智能发展。独裁政府计划采用新系统引发思考,第二层监控和犯罪前预测计划上线,娱乐公司试图平息异议者但并非所有人都喜闻娱乐,媒体对革命故事的展示可能影响真正的革命。

「 融资快讯 」

◇ 「Iambic Therapeutics」获 1 亿美元 B 轮融资,加速发展人工智能药物研发平台 🔗 News

Iambic Therapeutics 是一家位于加利福尼亚州圣地亚哥的生物技术公司,使用人工智能平台研发新型药物。最近完成了 1 亿美元的 B 轮融资,计划推动多个药物进入临床开发,扩大产品管线,并继续发展下一代人工智能和自动化技术。公司的人工智能平台结合物理学原理,提高了药物设计的效率,发现了两种可进入临床的候选药物,并创建了 NeuralPLexer 和 OrbNet 等工具来推动平台的发展。

「 机器人领域 」

◇ GenSim:通过大型语言模型生成机器人仿真任务 🔗 Twitter

GenSim 可以利用大型语言模型(LLM)的能力自动生成丰富的模拟环境和专家演示。GenSim 有两种模式:目标导向生成,其中 LLM 提供目标任务并生成相关任务;以及探索性生成,LLM 从先前任务中提取新任务。通过使用 GPT4 扩展现有基准任务并进行微调,该方法在多任务策略训练中显著增强了任务级泛化能力。最终通过模拟到现实的适应,这些预训练策略在长期任务上表现出更强的迁移能力,相较于基线高出 25%。

- Website: liruiw.github.io/gensim/

- Demo: huggingface.co/spaces/Gen-…

「 技术阅读 」

◇ 利用 LLMs 生成综合数据集 🔗 Twitter

利用大型语言模型生成合成数据集,解决了机器学习中缺乏标记数据的问题。这个技术允许我们依赖大型语言模型的泛化能力,几乎立即测试新想法或开发 AI 功能。其中一项令人兴奋的应用是使用 LLM 生成合成数据集,以训练新一代模型,尤其在资源有限的语言或特定领域中性能显著提升。

- 为 RAG 生成合成数据集:www.promptingguide.ai/application…

- 解决生成的数据集的多样性:www.promptingguide.ai/application…

◇ 如何改进 RAG 系统 🔗 Twitter

![[Release] Tree Of Savior](https://www.nicekj.com/wp-content/uploads/replace/4f98107ca1ebd891ea38f390f1226e45.png)

![[一键安装] 手游-天道情缘](https://www.nicekj.com/wp-content/uploads/replace/b441383e0c7eb3e52c9980e11498e137.png)

![[一键安装] 霸王大陆EP8-5.0 虚拟机+源码+大背包+商城-最新整理](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_0d204bcf457d56afaeacf1e97e86ee45.png)

![[一键安装] 龙之谷手游飓风龙单机版一键端 完整GM后台局域网](https://www.nicekj.com/wp-content/uploads/thumb/replace/fill_w372_h231_g0_mark_77ae8bb495cba3dd592ef131cc7aea5f.jpeg)